Ollama(本地LLM管理/WebUI对话) for Windows v0.5.7 安装免费版

- 大小:740MB

- 分类:编程工具

- 环境:Windows

- 更新:2025-02-07

热门排行

简介

Ollama是一个开源的 LLM(大型语言模型)服务工具,用于简化在本地运行大语言模型、降低使用大语言模型的门槛,使得大模型的开发者、研究人员和爱好者能够在本地环境快速实验、管理和部署最新大语言模型,支持与DeepSeek R1模型搭配本地部署,还包括如Qwen2、Llama3、Phi3、Gemma2等开源的大型语言模型。

Ollama 与 Llama 有什么关系?

Llama是 Meta 公司开源的备受欢迎的一个通用大语言模型,和其他大模型一样,Llama可以通过Ollama进行管理部署和推理等。

因此,Ollama与Llama的关系:Llama是大语言模型,而Ollama是大语言模型(不限于Llama模型)便捷的管理和运维工具,它们只是名字后面部分恰巧相同而已!

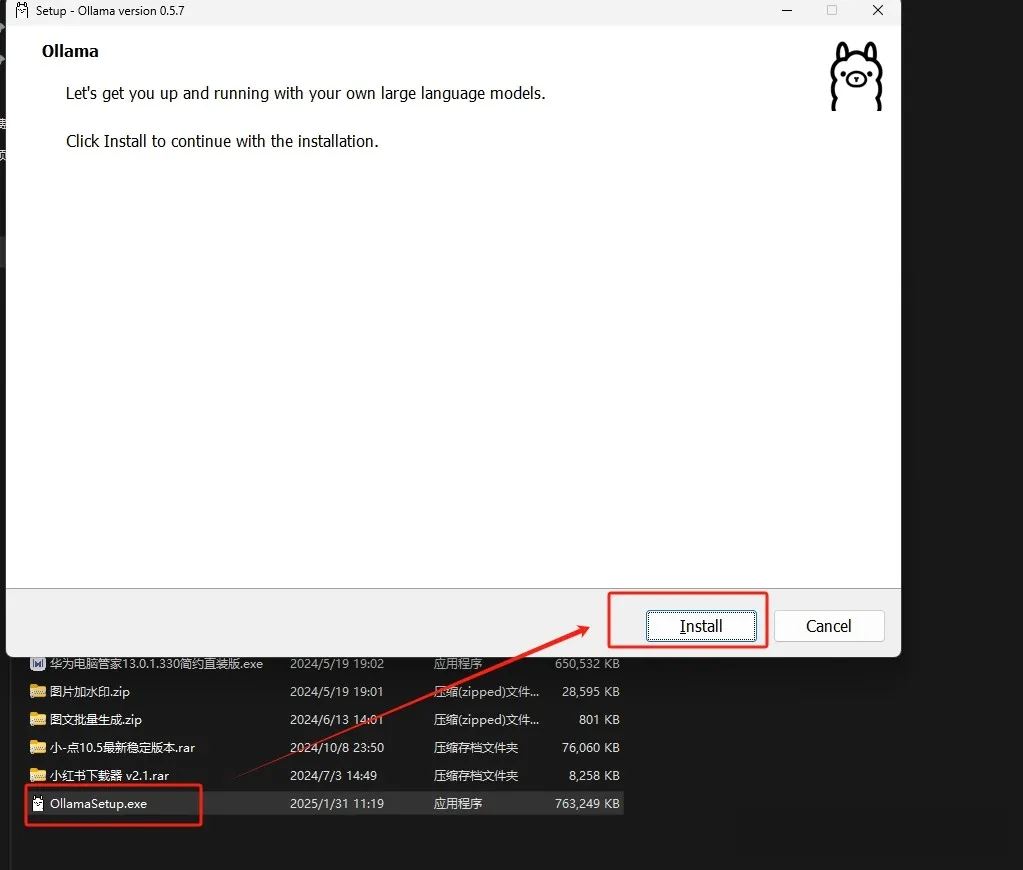

Ollama 安装和常用系统参数设置

Ollama的安装过程,与安装其他普通软件并没有什么两样。

安装完成之后,有几个常用的系统环境变量参数建议进行设置:

OLLAMA_MODELS:模型文件存放目录,默认目录为当前用户目录(Windows 目录:C:\Users%username%.ollama\models,MacOS 目录:~/.ollama/models,Linux 目录:/usr/share/ollama/.ollama/models),如果是 Windows 系统建议修改(如:D:\OllamaModels),避免 C 盘空间吃紧

OLLAMA_HOST:Ollama 服务监听的网络地址,默认为127.0.0.1,如果允许其他电脑访问 Ollama(如:局域网中的其他电脑),建议设置成0.0.0.0,从而允许其他网络访问

OLLAMA_PORT:Ollama 服务监听的默认端口,默认为11434,如果端口有冲突,可以修改设置成其他端口(如:8080等)

OLLAMA_ORIGINS:HTTP 客户端请求来源,半角逗号分隔列表,若本地使用无严格要求,可以设置成星号,代表不受限制

OLLAMA_KEEP_ALIVE:大模型加载到内存中后的存活时间,默认为5m即 5 分钟(如:纯数字如 300 代表 300 秒,0 代表处理请求响应后立即卸载模型,任何负数则表示一直存活);我们可设置成24h,即模型在内存中保持 24 小时,提高访问速度

OLLAMA_NUM_PARALLEL:请求处理并发数量,默认为1,即单并发串行处理请求,可根据实际情况进行调整

OLLAMA_MAX_QUEUE:请求队列长度,默认值为512,可以根据情况设置,超过队列长度请求被抛弃

OLLAMA_DEBUG:输出 Debug 日志标识,应用研发阶段可以设置成1,即输出详细日志信息,便于排查问题

OLLAMA_MAX_LOADED_MODELS:最多同时加载到内存中模型的数量,默认为1,即只能有 1 个模型在内存中

CPU适配版本:

没有GPU:1.5B Q8推理 或者 8B Q4推理

4G GPU:8B Q4推理

8G GPU:32B Q4推理 或者 8B Q4推理

16G GPU:32B Q4推理 或者 32B Q8推理

24G GPU: 32B Q8推理 或者 70B Q2推理

根据个人配置安装合适版本。

DeepSeek R1 本地部署方法

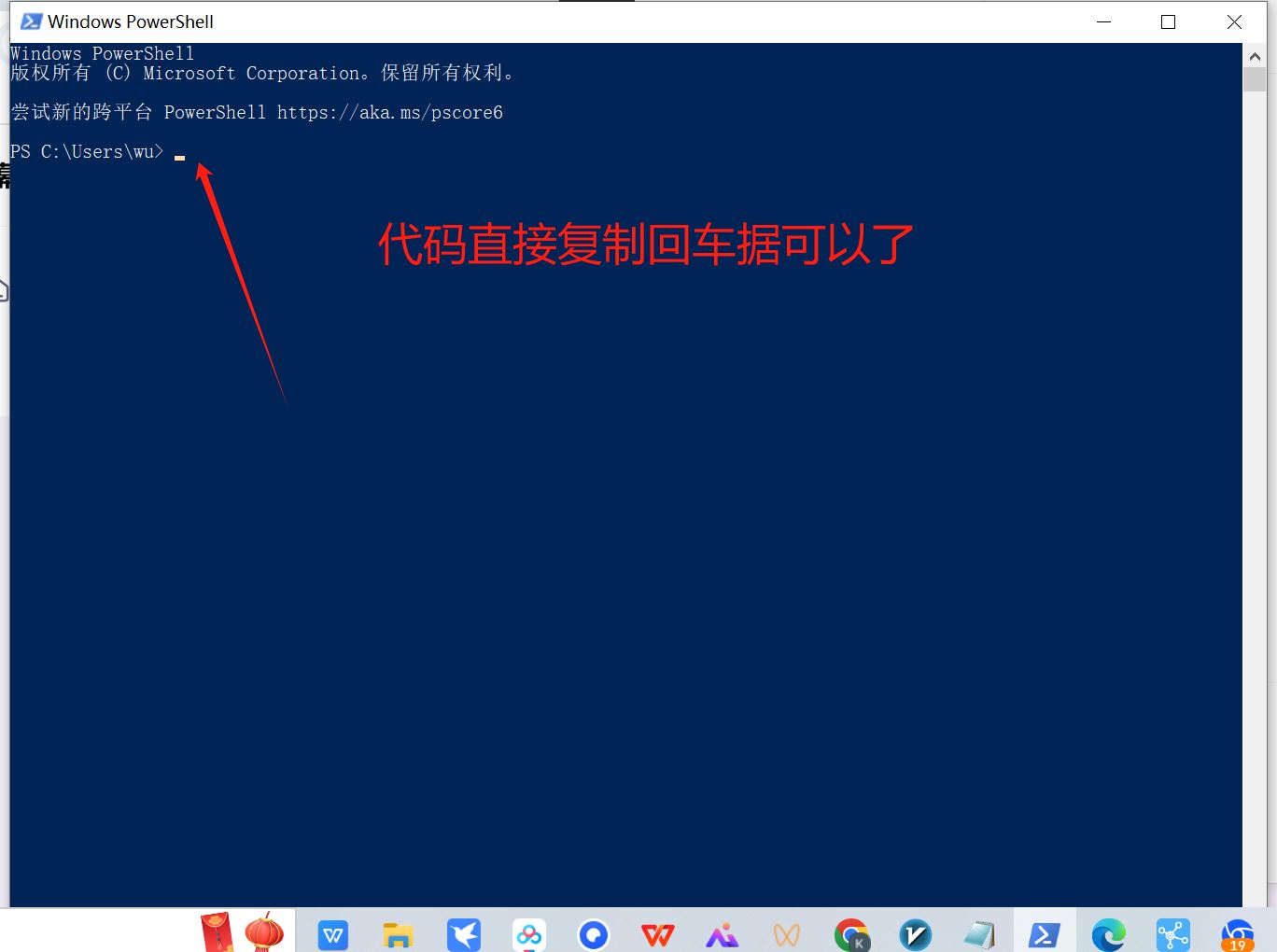

安装命令:

1.5B Qwen DeepSeek R1

安装命令:ollama run deepseek-r1:1.5b

7B Qwen DeepSeek R1

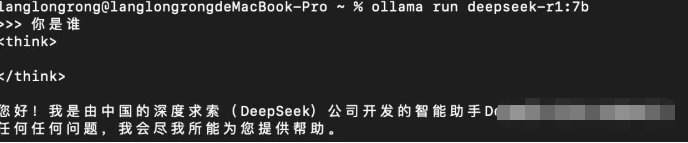

安装命令:ollama run deepseek-r1:7b

8B Llama DeepSeek R1

安装命令:ollama run deepseek-r1:8b

14B Qwen DeepSeek R1

安装命令:ollama run deepseek-r1:14b

32B Qwen DeepSeek R1

安装命令:ollama run deepseek-r1:32b

70B Llama DeepSeek R1

安装命令:ollama run deepseek-r1:70b

如果出现403,以管理员身份运行即可。

然后,会有一个漫长的下载模型的时间,下载后看到如下界面,证明你成功了!

搭建 web ui 用于网页对话

明显命令行这样的方式很不方便,无法满足对我们的聊天内容进行管理。这时,一个类似于Chat GPT这样的网页对话功能就显得十分重要了。

这里我选择的是Open web ui,具体效果如下。

下面讲解如何搭建,在此之前我们需要安装 docker 。

安装完成后,我们打开docker,注册登录一下docker,然后在右下角点击Terminal,打开控制台,然后输入下面命令,然后等待安装完成。

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

docker 容器启动后,会有欢迎页面,点击开始使用,开启体验之路!

其他Open WebUI可视化交互界面工具

目前我知道的大概有几种方式:

1、使用Docker-desktop,不仅是open-webui,其他绝大多数Github的开源项目都支持用docker一键部署,docker的好处是自带虚拟环境,不需要在本地额外安装一堆其他环境、依赖等,是管理、部署项目的神器。

2、自行安装Python环境,使用Pip的方式安装即可

3、不需要安装Docker-desktop,也不需要安装Python环境,直接使用浏览器Web UI插件就能搞定(下方就是教程,大家可以点击查看)

本地部署DeepSeek-R1联网 超简单的DeepSeek离线部署联网搜索教程

4、还可以使用ChatBox、Cherry Studio等桌面客户端都可以(下面也给大家提供了教程,点击查看)

chrome下载

chrome下载 知乎下载

知乎下载 Kimi下载

Kimi下载 微信下载

微信下载 天猫下载

天猫下载 百度地图下载

百度地图下载 携程下载

携程下载 QQ音乐下载

QQ音乐下载