DeepSeek服务器繁忙怎么解决?手把手教你本地连接DeepSeek R1告别不响应

脚本之家

最近DeepSeek火爆出圈,整的官网和APP经常服务器繁忙,没办法对话。今天给大家分享一个本地就能接入DeepSeek的办法,按照这个方法几分钟就能搞定。本次使用的CherryStudio + DeepSeek R1本地部署的方法(稍繁琐,但免费),当然大家也可以选用最简单的CherryStudio + DeepSeek R1 API密钥的方式,更便捷,就是不免费。大家可以根据自身需求,进行选择。

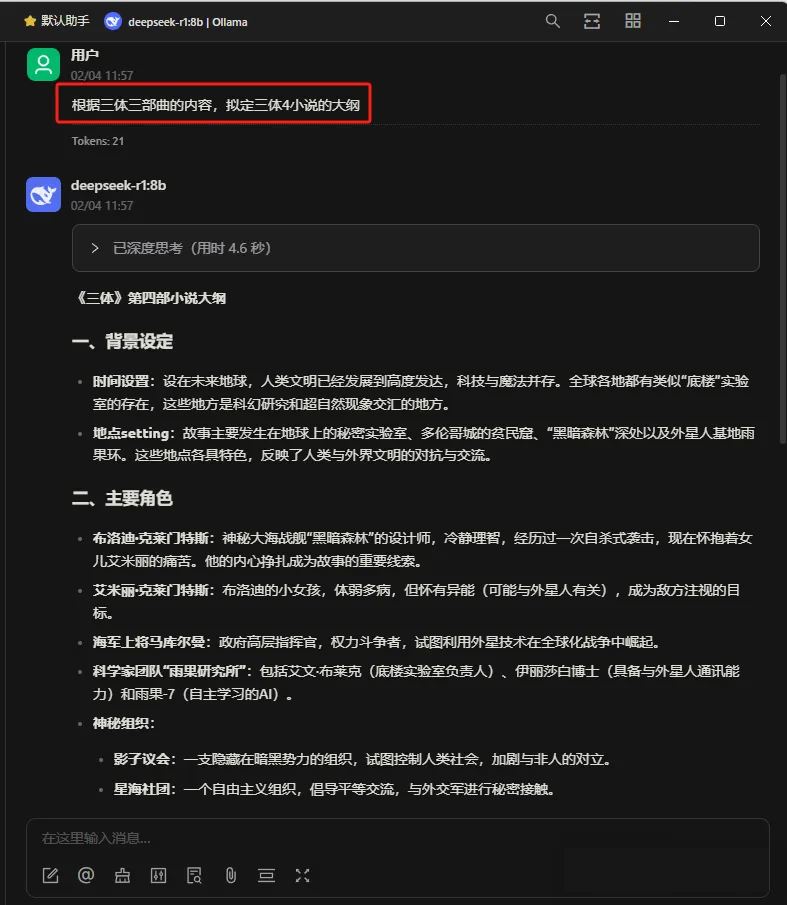

老规矩,先看效果:

Cherry Studio介绍

CherryStudio不仅可以连接DeepSeek,如果你有其它大模型的API秘钥,同样也可以直接连接使用,方法一样,不需要收藏多个网站,属于一个大模型集合工具,还是很不错的。

简单理解,就是Cherry Studio里面内置集成了很多大模型服务商,

这样我们只需要做些简单的配置就可以使用大模型了。

而且是可视化界面,交互操作起来就比较方便。

具体实操

那么整体步骤就三步:

1、安装Cherry Studio客户端

2、配置Ollama模型

3、验证Ollama模型

安装Cherry Studio客户端

下载Cherry Studio安装包

等待下载完成

如果出现浏览器提示文件不被信任等情况选择保留即可

选择【保留】→ 【信任 Cherry-Studio】

打开文件。

安装成功。

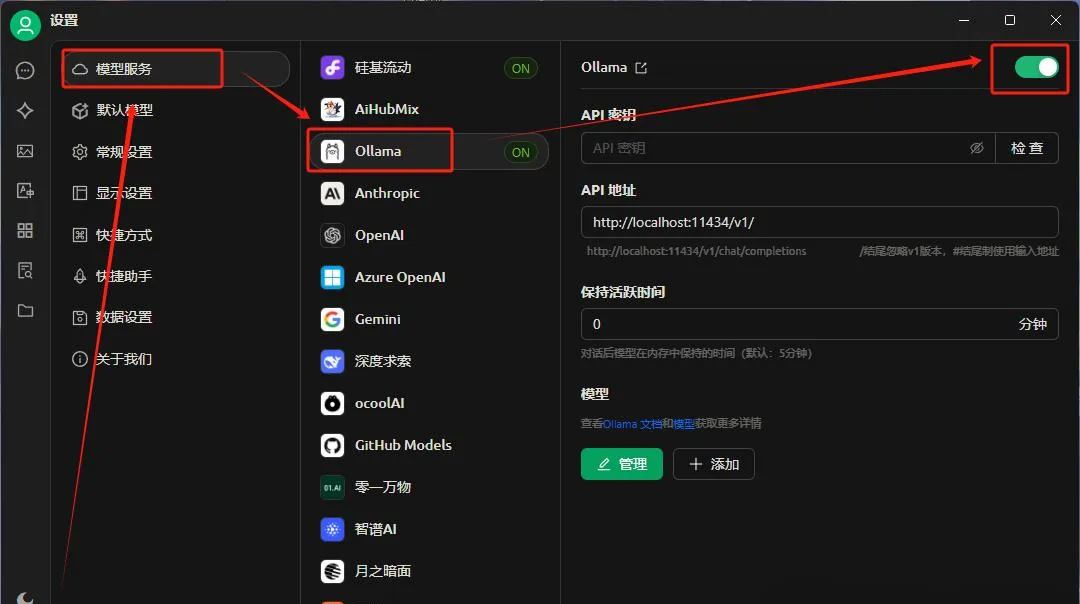

配置Ollama模型

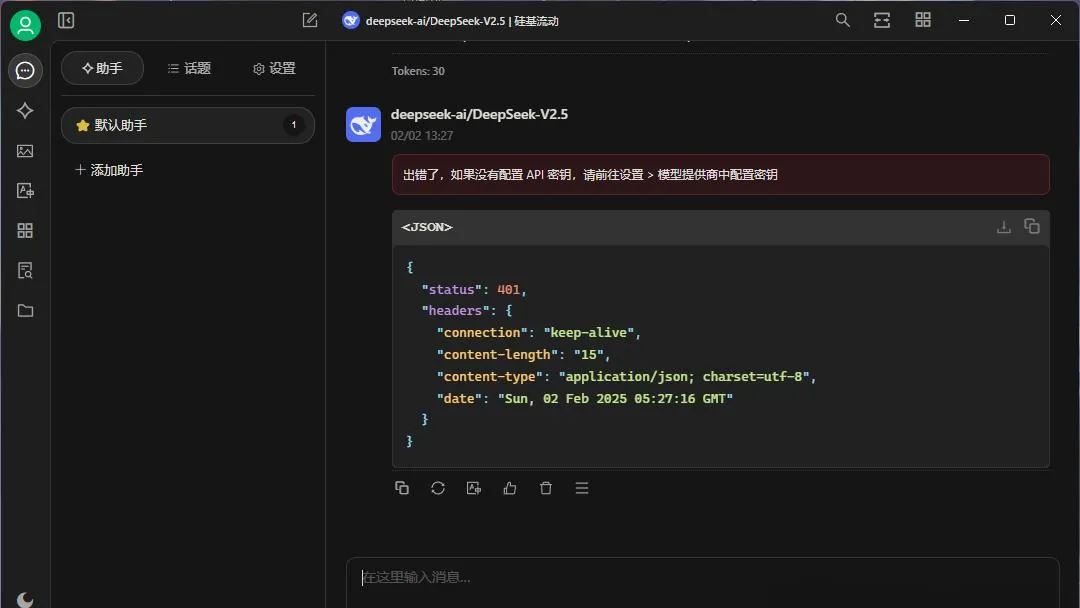

如果不配置API,是操作不了的。会提示错误

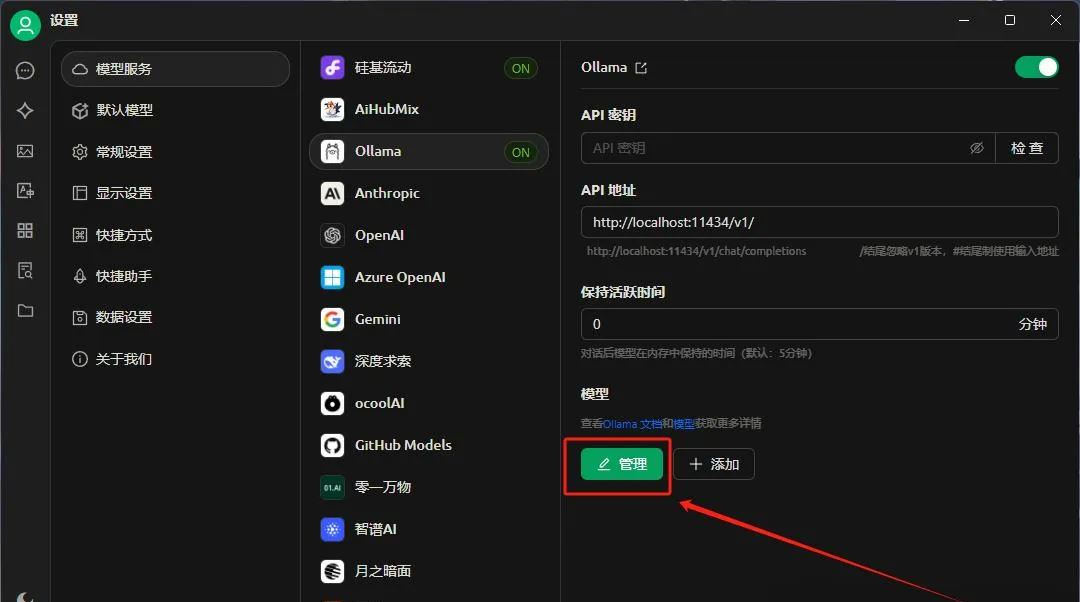

左下角【设置】——》【模型服务】——》Ollama——》开启

点击下方【管理】

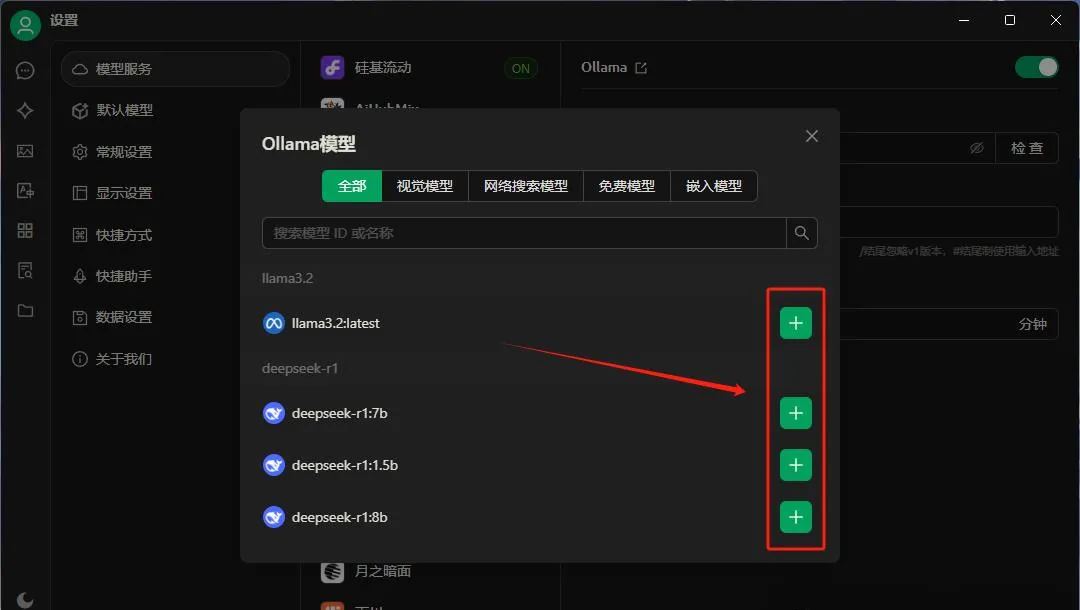

如果本地Ollama服务已经开启了,会自动加载出DeepSee推理模型,然后添加自己需要的

本地Ollama服务开启方法请查看: DeepSeek R1 本地部署详细图文教程

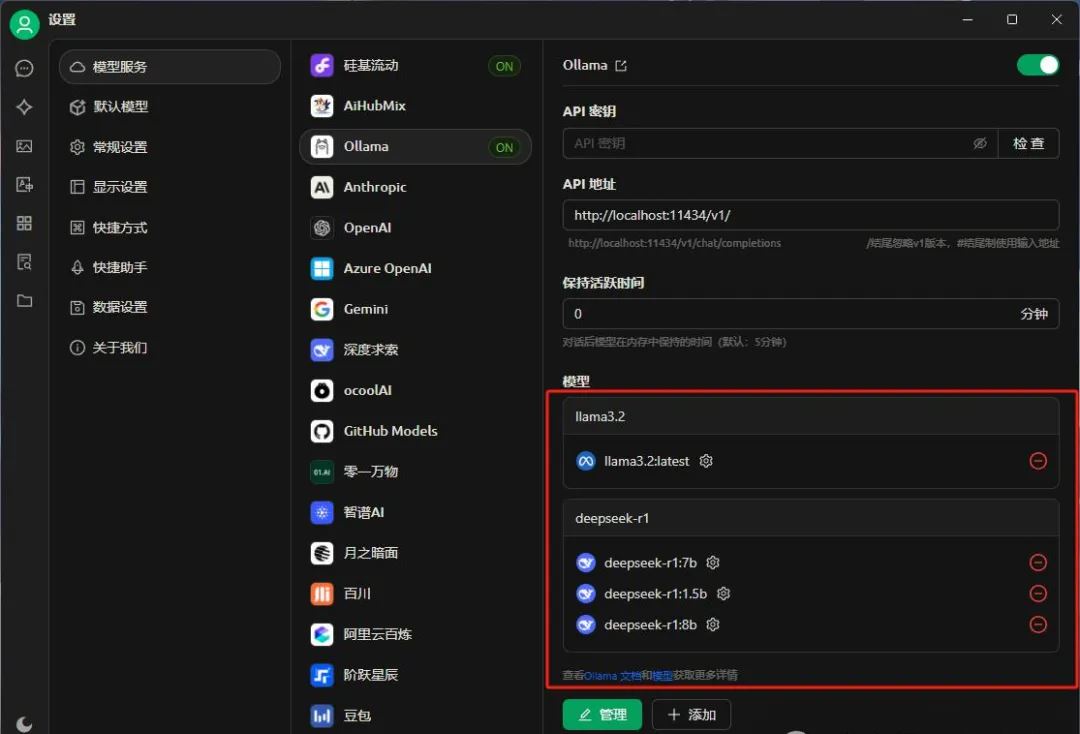

DeepSee推理模型添加成功

验证Ollama模型

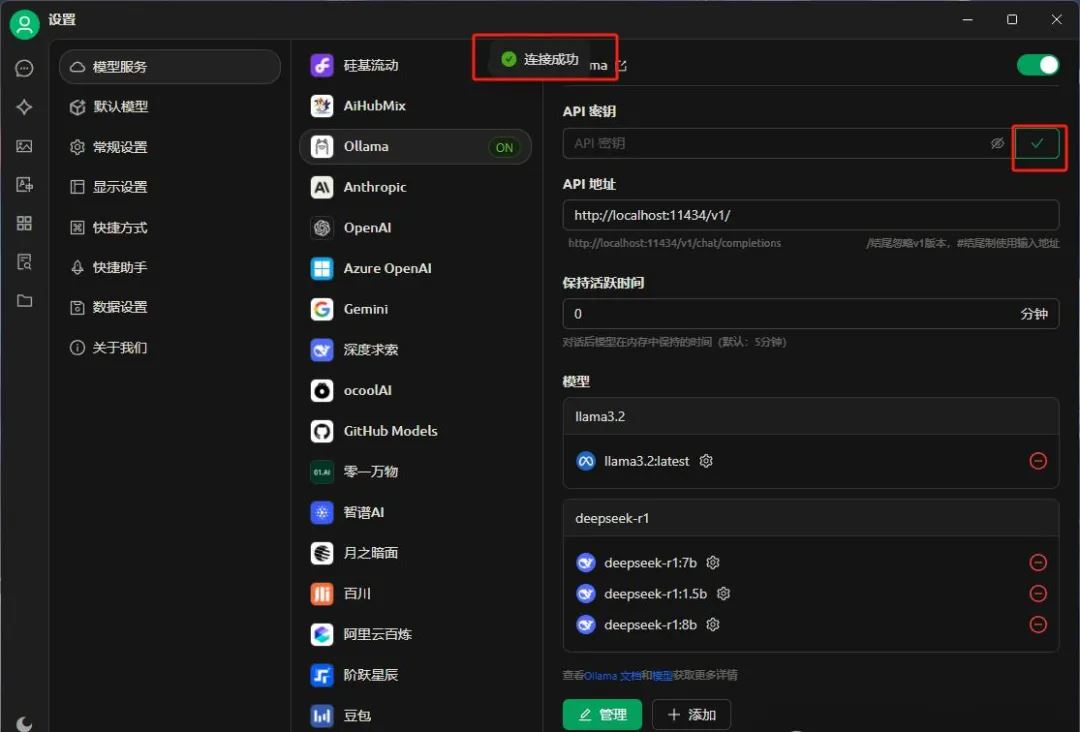

然后我们验证一下API服务情况。

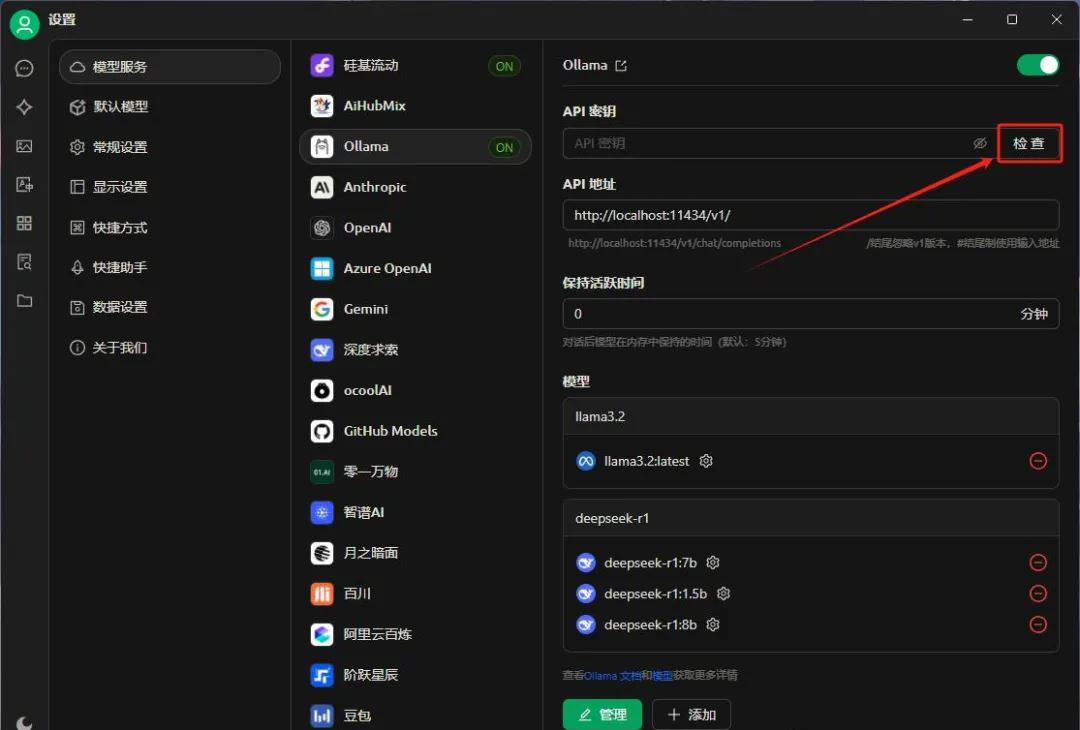

这里注意,如果本地已经部署了Ollama服务,不需要填写API密钥,否则需要去官网申请API密钥

不想申请API密钥的伙伴,请先查看:DeepSeek R1 本地部署详细图文教程

这里因为我本地已经部署了Ollama服务,所以不需要填写API密钥,直接点击【检查】即可

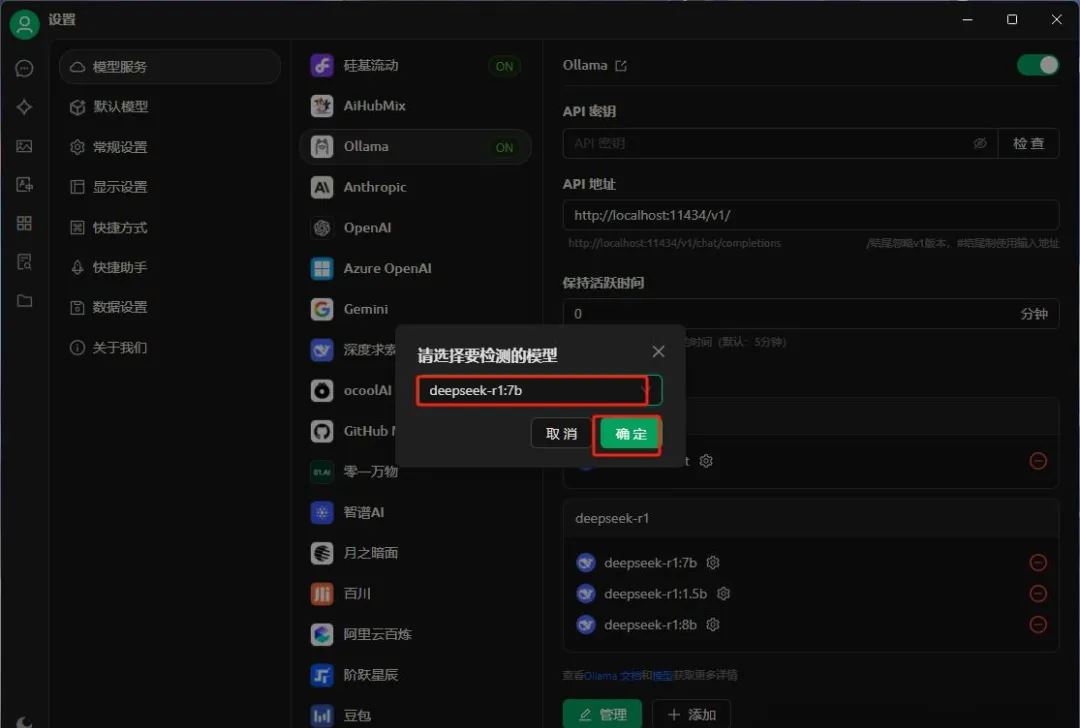

选择要检测的模型进行验证

如果验证成功,会提示【连接成功】

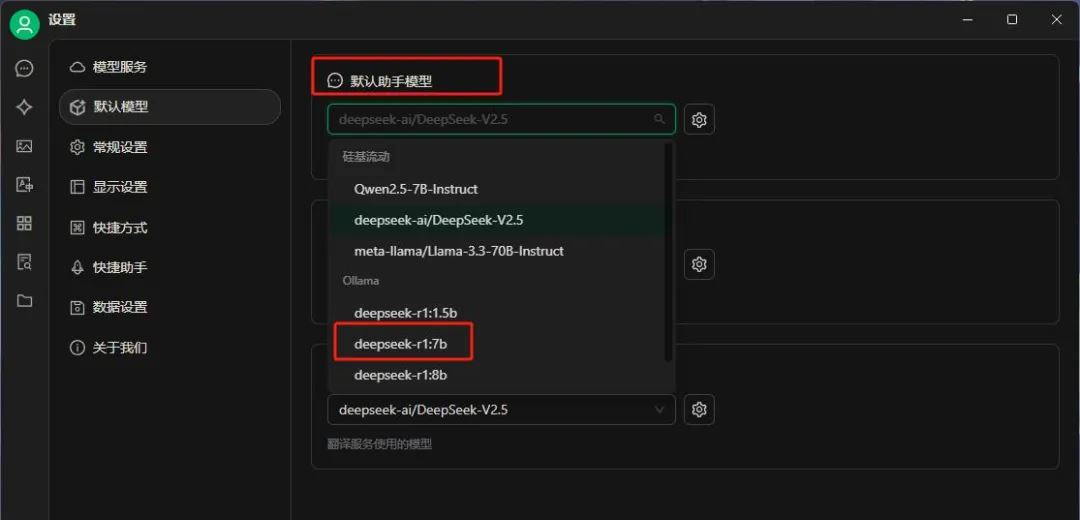

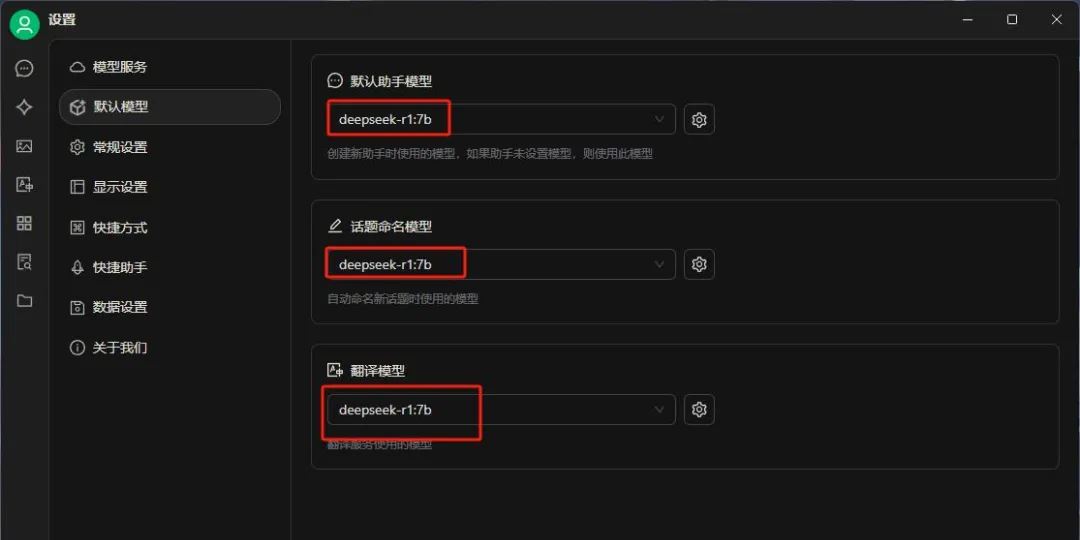

设置【默认模型】,这里我设置的是deepseek-r1:7b的推理模型

到这里,整个安装步骤就完成了,

接下来去正常对话就行了。

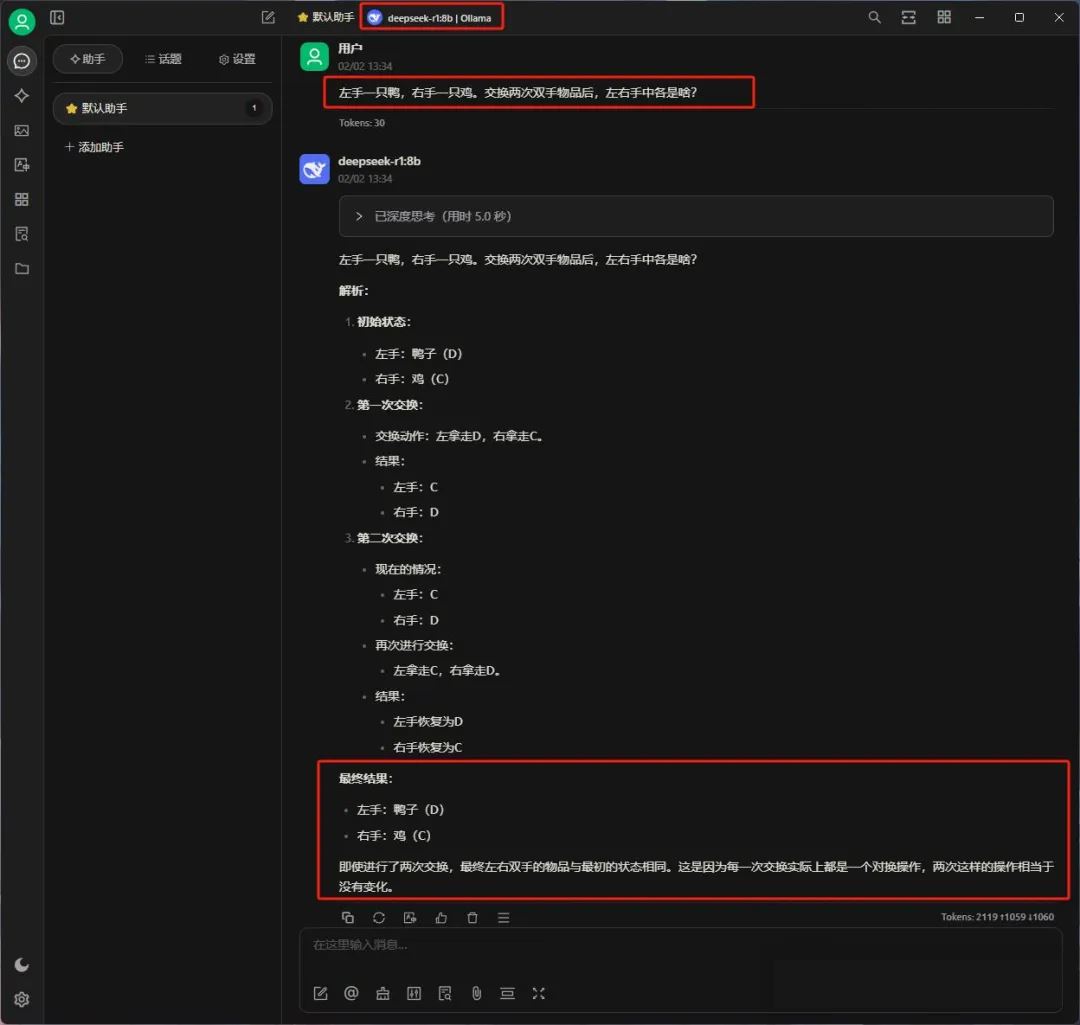

左手一只鸭,右手一只鸡。交换两次双手物品后,左右手中各是啥?

DeepSeek R1的本地部署为用户提供了一个强大且私密的AI助手选择。通过合理选择模型版本和正确的部署步骤,你可以在保护隐私的同时享受先进的AI技术带来的便利。