尖叫青蛙Screaming Frog SEO Spider(网络爬虫开发软件) v19.2 特别安装版

- 大小:614MB

- 分类:网络监测

- 环境:Windows

- 更新:2023-09-07

热门排行

简介

Screaming Frog SEO Spider是一款好用的网络爬虫开发工具,该软件可以分析指定的URL,并在单独的选项卡中查看内部和外部链接的列表。除此之外,您还可以检查多个链接的响应时间,查看页面标题,它们的出现次数,长度和像素宽度。感兴趣的朋友千万不要错过了。

破解教程

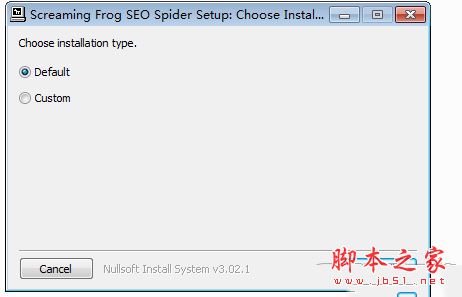

1.点击ScreamingFrogSEOSpider-11.1.exe启动软件的安装,点击install安装就可以了

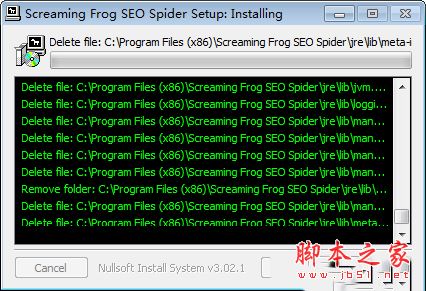

2.显示安装的过程,您可以在这里设置需要安装的数据,等待安装完成

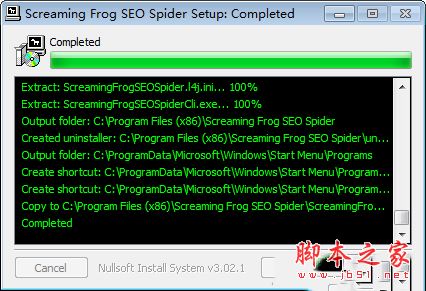

3.提示您Completed说明安装完成,点击close结束软件的安装

4.点击启动软件,这里是Screaming Frog SEO Spider的一些官方提示,点击accept同意协议

5.进入软件,点击Licence许可证就可以显示激活的界面了

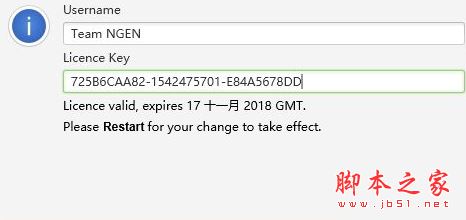

6.打开您下载的注册机软件,将得到的序列号输入软件就可以完成激活了

7.如图所示,输入Team NGEN,填写注册码725B6CAA82-1542475701-E84A5678DD

软件特色

1、找到断开的链接

立即抓取网站,找到损坏的链接(404)和服务器错误。批量导出错误和源URL以修复或发送给开发人员。

2、审计重定向

找到临时和永久的重定向,识别重定向链和循环,或者上传一个网址列表,以在网站迁移中进行审计。

3、分析页面标题和元数据

在抓取过程中分析页面标题和元描述,并确定在您的网站中过长,短小,缺失或重复的页面标题和元描述。

4、发现重复的内容

使用md5算法检查发现精确的重复网址、部分重复的网页标题、说明或标题等元素,并找到内容较低的网页。

5、使用XPath提取数据

使用CSS Path,XPath或regex从网页的HTML中收集任何数据。这可能包括社交元标签、额外的标题、价格、SKU或更多!

6、审查机器人和指令

查看由robots.txt、meta robots或X-Robots-Tag指令(如“noindex”或“nofollow”)以及canonicals和rel=“next”和rel=“prev”阻止的URL。

7、生成XML站点地图

快速创建XML站点地图和图像XML站点地图,通过包含URL的高级配置,上次修改,优先级和更改频率。

8、与Google Analytics集成

连接到Google AnalyticsAPI,并抓取用户数据,例如会话或跳出率和转化次数,目标,交易和着陆页的收入。

软件功能

1、查找断开的链接、错误和重定向

2、分析页面标题和元数据

3、审查元机器人和指令

4、审计hreflang属性

5、发现重复的页面

6、生成XML站点地图

7、爬网限制

8、抓取配置

9、保存抓取并重新上传

10、自定义源代码搜索

11、自定义提取

12、Google Analytics集成

13、Search Console集成

14、链接指标集成

15、JavaScript渲染抓取

16、自定义robots.txt抓取

使用简介

一、爬行抓取

1、常规抓取

在常规抓取模式下,Screaming Frog SEO Spider会抓取您输入的子域名,并将默认情况下所遇到的所有其他子域名视为外部链接(显示在“外部”标签下)。在该软件的许可版本中,您可以调整配置以选择抓取网站的所有子域。搜索引擎优化蜘蛛最常见的用途之一是在网站上发现错误,如断开的链接,重定向和服务器错误。为了更好地控制抓取,请使用您的网站的URI结构、SEO spider配置选项,例如只抓取HTML(图像、CSS、JS等)、排除功能、自定义robots.txt、包含功能或者更改搜索引擎优化蜘蛛的模式,并上传一个URI列表抓取。

2、抓取一个子文件夹

SEO Spider工具默认从子文件夹路径向前抓取,因此如果您希望抓取站点上的特定子文件夹,只需输入具有文件路径的URI即可。例如,如果它是一个博客,它可能是:https://www.screamingfrog.co.uk/blog/,就像我们自己的博客。通过直接输入到SEO Spider中,它将抓取/blog/sub目录中包含的所有URI。

3、抓取网址列表

通过输入网址并点击“开始”来抓取网站,您可以切换到列表模式,粘贴或上传要抓取的特定网址列表。例如,在审计重定向时,这对于站点迁移尤其有用。

二、组态

在该工具的许可版本中,您可以保存默认的爬网配置,并保存可在需要时加载的配置配置文件。

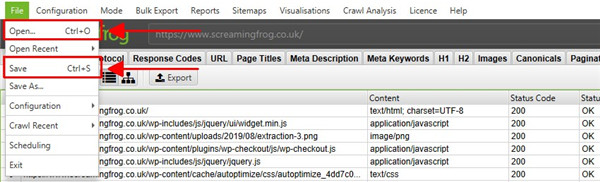

1、要将当前配置保存为默认值,请选择“文件>配置>将当前配置保存为默认值”。

2、要保存配置文件以便将来可以加载,请单击“文件>另存为”并调整文件名(最好是描述性的)。

3、要加载配置文件,请单击“文件>加载”,然后选择您的配置文件或“文件>加载最近”以从最近的列表中进行选择。

4、要重置为原始Screaming Frog SEO Spider默认配置,请选择“文件>配置>清除默认配置”。

三、出口

顶部窗口部分的导出功能在顶部窗口中与您当前的视野一起工作。因此,如果您使用过滤器并单击“导出”,则只会导出过滤选项中包含的数据。

有三种主要的数据导出方法:

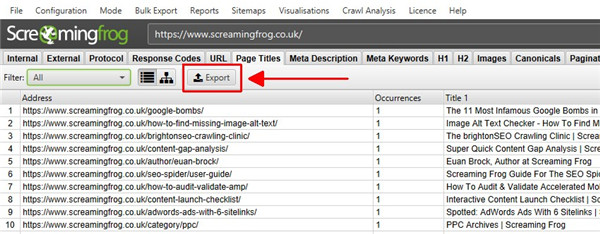

1、导出顶层窗口数据:只需点击左上角的“导出”按钮,即可从顶层窗口选项卡导出数据。

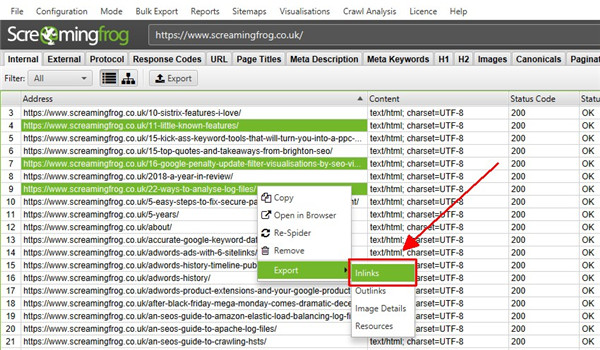

2、导出较低的窗口数据(URL信息、链接、输出链接、图像信息):要导出这些数据,只需在顶部窗口中右键单击要导出数据的URL,然后单击“导出”下的“URL信息”、“链接”、“出链接”或“图片信息”。

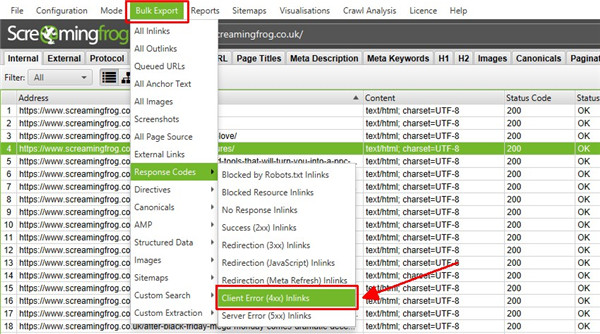

3、批量导出:位于顶层菜单下,允许批量导出数据。您可以通过“all in links”选项导出抓取中找到的链接的所有实例,也可以将所有链接全部导出到具有特定状态代码(如2XX,3XX,4XX或5XX响应)的URL。例如,选择“链接中的客户端错误4XX”选项将导出全部链接到所有错误页面(例如404错误页面)。您还可以导出所有图像替代文字,所有图像缺少替代文字和所有锚点文字。

软件特色1、查找损坏的链接

立即抓取网站并找到损坏的链接 (404) 和服务器错误。批量导出错误和源 URL 以修复或发送给开发人员。

2、审计重定向

查找临时和永久重定向,识别重定向链和循环,或上传要在站点迁移中审核的 URL 列表。

3、分析页面标题和元数据

在抓取过程中分析页面标题和元描述,并找出网站中过长、过短、缺失或重复的页面标题和元描述。

4、发现重复内容

使用 md5 算法检查发现完全重复的 URL,部分重复的元素,如页面标题、描述或标题,并找到低内容页面。

5、使用 XPath 提取数据

使用 CSS Path、XPath 或正则表达式从网页的 HTML 中收集任何数据。这可能包括社交元标签、附加标题、价格、SKU 或更多!

6、查看机器人和指令

查看被 robots.txt、元机器人或 X-Robots-Tag 指令(例如“noindex”或“nofollow”)以及规范和 rel="next" 和 rel="prev" 阻止的 URL。

7、生成 XML 站点地图

快速创建 XML 站点地图和图像 XML 站点地图,对 URL 进行高级配置以包括、上次修改、优先级和更改频率。

8、与 GA、GSC 和 PSI 集成

连接到 Google Analytics、Search Console 和 PageSpeed Insights API,并在抓取中获取所有 URL 的用户和性能数据以获得更深入的洞察。

9、抓取 JavaScript 网站

使用集成的 Chromium WRS 呈现网页,以抓取动态的、富含 JavaScript 的网站和框架,例如 Angular、React 和 Vue.js。

10、可视化站点架构

使用交互式爬网和目录力导向图以及树形图站点可视化来评估内部链接和 URL 结构。

11、安排审计

安排抓取以选定的时间间隔运行,并将抓取数据自动导出到任何位置,包括 Google 表格。或者通过命令行完全自动化。

12、比较爬网和登台

跟踪 SEO 问题和机会的进展,并查看爬行之间的变化。使用高级 URL 映射将暂存与生产环境进行比较。

尖叫青蛙使用教程

1、开始爬行

有两种主要的爬行模式。抓取网站的默认“蜘蛛”模式或“列表”,允许您上传要抓取的 URL 列表。

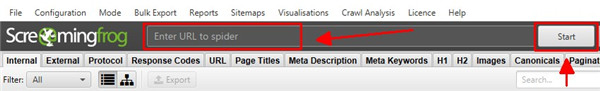

您可以通过将主页插入到“输入蜘蛛的 URL”字段并单击“开始”来开始常规的“蜘蛛”抓取。

这将抓取和审核输入的 URL,以及它可以通过同一子域上页面的 HTML 中的超链接发现的所有 URL。

这将抓取和审核输入的 URL,以及它可以通过同一子域上页面的 HTML 中的超链接发现的所有 URL。

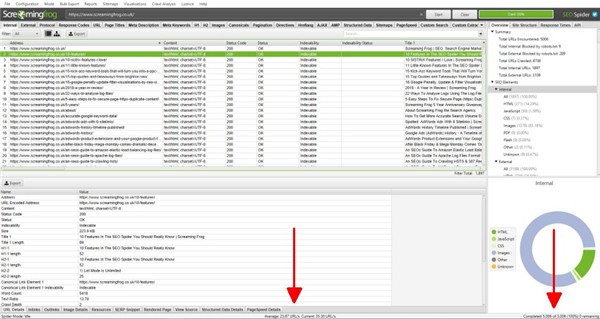

爬取会实时更新,速度和完成和剩余的URL总数可以在应用程序底部查看。

您可以单击“暂停”,也可以随时“恢复”抓取。您还可以保存抓取并稍后恢复,稍后将详细了解保存。

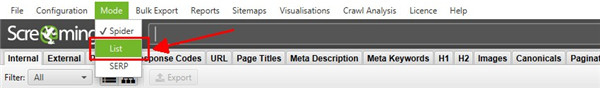

如果您更愿意抓取 URL 列表而不是完整站点,请单击“模式 > 列表”以上传或粘贴 URL 列表。

2、配置爬网

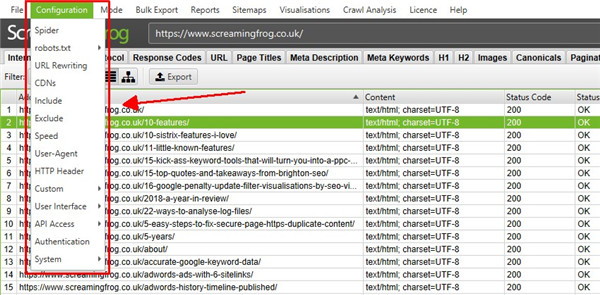

您无需调整配置即可抓取网站,因为 SEO Spider 默认设置为以与 Google 类似的方式抓取。

但是,您可以通过多种方式配置爬网以获取所需数据。查看工具中“配置”下的选项,并参阅我们的用户指南以了解有关每个设置的详细信息。

一些最常见的控制抓取内容的方法是抓取特定的子文件夹、使用排除(以避免按 URL 模式抓取 URL)或包含功能。

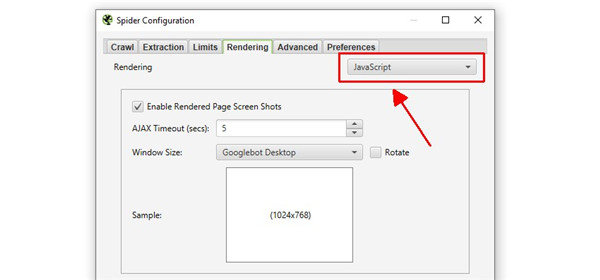

如果您的网站依赖 JavaScript 来填充内容,您还可以在“配置 > 蜘蛛 > 渲染”下切换到JavaScript 渲染模式。

这意味着 JavaScript 被执行,SEO Spider 将在呈现的 HTML 中抓取内容和链接。

3、查看抓取数据

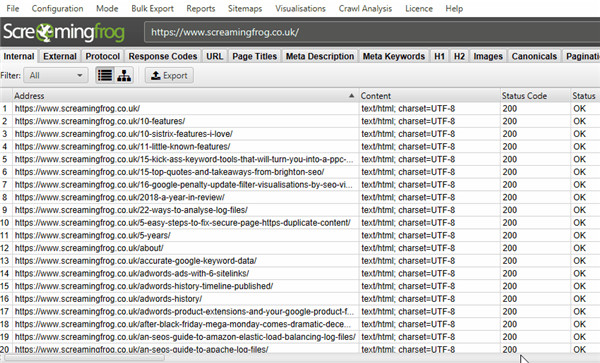

来自爬行的数据在 SEO Spider 中实时填充并显示在选项卡中。“内部”选项卡包括在对被爬行的网站的爬行中发现的所有数据。您可以上下滚动并向右滚动以查看各个列中的所有数据。

这些选项卡关注不同的元素,每个元素都有过滤器,可帮助按类型和发现的潜在问题优化数据。

这些选项卡关注不同的元素,每个元素都有过滤器,可帮助按类型和发现的潜在问题优化数据。

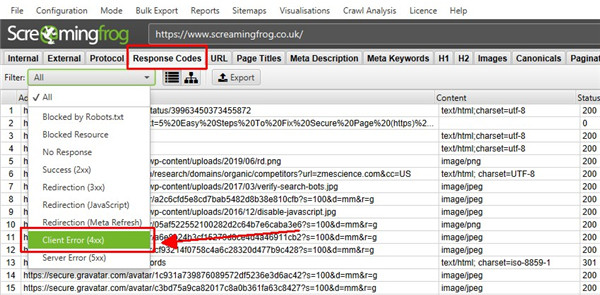

例如,“响应代码”选项卡和“客户端错误 (4xx)”过滤器将显示发现的任何 404 页面。

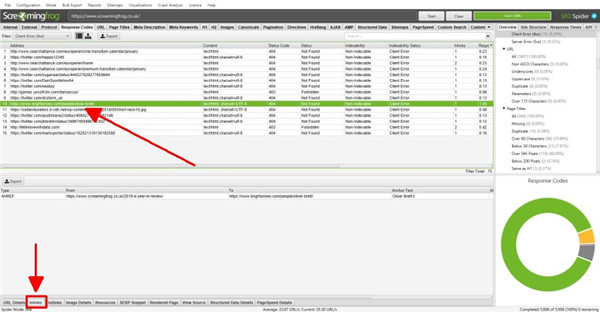

您可以单击顶部窗口中的 URL,然后单击底部的选项卡以填充下部窗口窗格。

这些选项卡提供有关 URL 的更多详细信息,例如它们的内链接(链接到它们的页面)、外链接(它们链接到的页面)、图像、资源等。

在上面的示例中,我们可以看到在抓取过程中发现的损坏链接的内链。

4、发现错误和问题

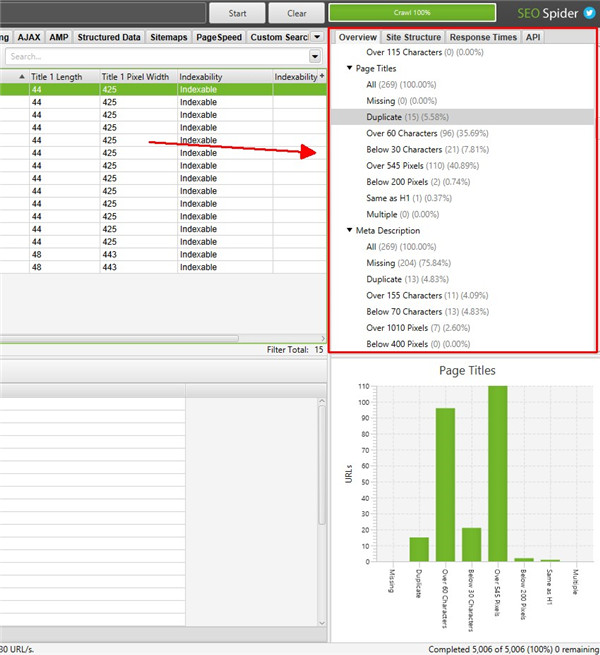

右侧窗口的“概览”选项卡显示包含在每个选项卡和过滤器中的爬网数据的摘要。您可以滚动浏览每个部分以识别发现的潜在错误和问题,而无需单击每个选项卡和过滤器。

在大多数过滤器的抓取过程中,受影响的 URL 数量会实时更新,您可以单击它们直接转到相关选项卡和过滤器。

SEO Spider 不会告诉您如何进行 SEO,它会为您提供数据以做出更明智的决策。然而,“过滤器”确实提供了关于应该解决或至少在您的站点上下文中进一步考虑的特定问题的提示。

探索这些提示,如果您不确定选项卡或过滤器的含义,请参阅我们的用户指南。每个选项卡都有一个部分(例如页面标题、规范和指令)来解释每个列和过滤器。

5、导出数据

您可以将所有数据从爬网导出到电子表格中。只需单击左上角的“导出”按钮即可从顶部窗口选项卡和过滤器导出数据。

要导出下部窗口数据,请在顶部窗口中右键单击要从中导出数据的 URL,然后单击选项之一。

还有一个位于顶级菜单下的“批量导出”选项。这允许您导出源链接,例如带有特定状态代码(如 2XX、3XX、4XX 或 5XX 响应)的 URL 的“inlinks”。

在上面,选择上面的“Client Error 4XX In Links”选项将导出所有链接到所有错误页面(链接到 404 错误页面的页面)。

6、保存和打开抓取

您只能使用许可证保存和打开爬网。在默认内存存储模式下,您可以随时(暂停或完成时)保存抓取并通过选择“文件 > 保存”或“文件 > 打开”重新打开。

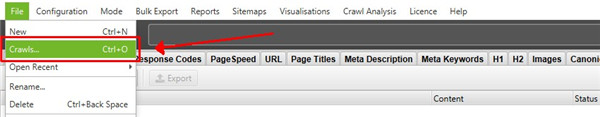

在数据库存储模式下,爬网会在爬网过程中自动“保存”并提交到数据库中。要打开爬网,请单击主菜单中的“文件 > 爬网”。

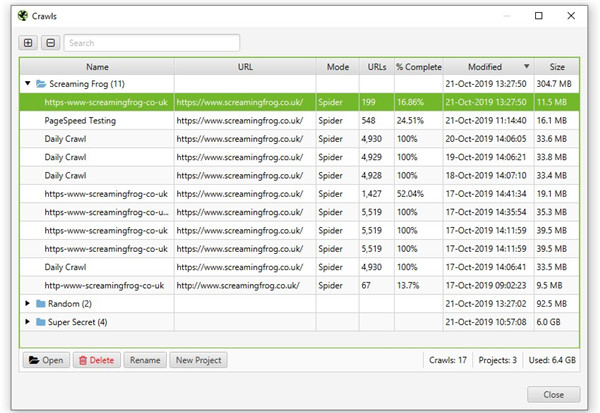

“抓取”窗口显示自动存储抓取的概览,您可以在其中打开、重命名、组织到项目文件夹中、复制、导出或批量删除它们。

chrome下载

chrome下载 知乎下载

知乎下载 Kimi下载

Kimi下载 微信下载

微信下载 天猫下载

天猫下载 百度地图下载

百度地图下载 携程下载

携程下载 QQ音乐下载

QQ音乐下载