华为昇腾920b服务器部署DeepSeek翻车现场演示

作者:是小V呀

最近到祸一台HUAWEI Kunpeng 920 5250,先看看配置。之前是部署的讯飞大模型,发现资源利用率太低了。把5台减少到3台,就出了他

硬件配置信息

基本硬件信息

按照惯例先来看看配置。一共3块盘,500G的系统盘,+ 2块3T固态,后面把固态硬盘也组合成了逻辑卷

内存是1.5T的,比我电脑硬盘都大

[root@localhost ~]# lsblk NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINTS sda 8:0 0 446.6G 0 disk ├─sda1 8:1 0 600M 0 part /boot/efi ├─sda2 8:2 0 1G 0 part /boot └─sda3 8:3 0 445G 0 part ├─openeuler-root 253:0 0 70G 0 lvm / ├─openeuler-swap 253:1 0 4G 0 lvm [SWAP] └─openeuler-home 253:2 0 371G 0 lvm /home nvme1n1 259:0 0 2.9T 0 disk └─nvme1n1p1 259:4 0 2.9T 0 part └─vg_data01-lv_data01 253:3 0 5.8T 0 lvm /data nvme0n1 259:1 0 2.9T 0 disk └─nvme0n1p1 259:3 0 2.9T 0 part └─vg_data01-lv_data01 253:3 0 5.8T 0 lvm /data [root@localhost ~]# df -Th | awk '$2 !~ /overlay/ && $2 !~ /tmpfs/' 文件系统 类型 容量 已用 可用 已用% 挂载点 /dev/mapper/openeuler-root ext4 69G 45G 21G 69% / /dev/sda2 ext4 974M 72M 835M 8% /boot /dev/sda1 vfat 599M 5.8M 594M 1% /boot/efi /dev/mapper/openeuler-home ext4 365G 4.6G 342G 2% /home /dev/mapper/vg_data01-lv_data01 ext4 5.8T 4.3T 1.3T 78% /data

[root@localhost ~]# cat /etc/os-release

NAME="openEuler"

VERSION="22.03 LTS"

ID="openEuler"

VERSION_ID="22.03"

PRETTY_NAME="openEuler 22.03 LTS"

ANSI_COLOR="0;31"

[root@localhost ~]# uname -a

Linux localhost.localdomain 5.10.0-60.18.0.50.oe2203.aarch64 #1 SMP Wed Mar 30 02:43:08 UTC 2022 aarch64 aarch64 aarch64 GNU/Linux

[root@localhost ~]# lscpu

架构: aarch64

CPU 运行模式: 64-bit

字节序: Little Endian

CPU: 192

在线 CPU 列表: 0-191

厂商 ID: HiSilicon

BIOS Vendor ID: HiSilicon

型号名称: Kunpeng-920

BIOS Model name: HUAWEI Kunpeng 920 5250

型号: 0

每个核的线程数: 1

每个座的核数: 48

座: 4

步进: 0x1

Frequency boost: disabled

CPU 最大 MHz: 2600.0000

CPU 最小 MHz: 200.0000

BogoMIPS: 200.00

标记: fp asimd evtstrm aes pmull sha1 sha2 crc32 atomics fphp asimdhp cpuid asimdrdm jscvt fcma dcpop asimddp asimdfhm ssbs

Caches (sum of all):

L1d: 12 MiB (192 instances)

L1i: 12 MiB (192 instances)

L2: 96 MiB (192 instances)

L3: 192 MiB (8 instances)

NUMA:

NUMA 节点: 8

NUMA 节点0 CPU: 0-23

NUMA 节点1 CPU: 24-47

NUMA 节点2 CPU: 48-71

NUMA 节点3 CPU: 72-95

NUMA 节点4 CPU: 96-119

NUMA 节点5 CPU: 120-143

NUMA 节点6 CPU: 144-167

NUMA 节点7 CPU: 168-191

Vulnerabilities:

Itlb multihit: Not affected

L1tf: Not affected

Mds: Not affected

Meltdown: Not affected

Spec store bypass: Mitigation; Speculative Store Bypass disabled via prctl

Spectre v1: Mitigation; __user pointer sanitization

Spectre v2: Not affected

Srbds: Not affected

Tsx async abort: Not affected

[root@localhost ~]# free -h

total used free shared buff/cache available

Mem: 1.5Ti 12Gi 26Gi 20Mi 1.4Ti 1.5Ti

Swap: 4.0Gi 12Mi 4.0GiNPU/GPU信息

由于没有部署任何AI、模型,所以空载着

[root@localhost ~]# npu-smi info +------------------------------------------------------------------------------------------------+ | npu-smi 24.1.rc1 Version: 24.1.rc1 | +---------------------------+---------------+----------------------------------------------------+ | NPU Name | Health | Power(W) Temp(C) Hugepages-Usage(page)| | Chip | Bus-Id | AICore(%) Memory-Usage(MB) HBM-Usage(MB) | +===========================+===============+====================================================+ | 0 910B3 | OK | 89.7 35 0 / 0 | | 0 | 0000:C1:00.0 | 0 0 / 0 3159 / 65536 | +===========================+===============+====================================================+ | 1 910B3 | OK | 88.6 38 0 / 0 | | 0 | 0000:C2:00.0 | 0 0 / 0 3159 / 65536 | +===========================+===============+====================================================+ | 2 910B3 | OK | 91.8 36 0 / 0 | | 0 | 0000:81:00.0 | 0 0 / 0 3159 / 65536 | +===========================+===============+====================================================+ | 3 910B3 | OK | 87.2 36 0 / 0 | | 0 | 0000:82:00.0 | 0 0 / 0 3159 / 65536 | +===========================+===============+====================================================+ | 4 910B3 | OK | 88.8 41 0 / 0 | | 0 | 0000:01:00.0 | 0 0 / 0 3159 / 65536 | +===========================+===============+====================================================+ | 5 910B3 | OK | 95.7 44 0 / 0 | | 0 | 0000:02:00.0 | 0 0 / 0 3159 / 65536 | +===========================+===============+====================================================+ | 6 910B3 | OK | 93.5 39 0 / 0 | | 0 | 0000:41:00.0 | 0 0 / 0 3160 / 65536 | +===========================+===============+====================================================+ | 7 910B3 | OK | 89.2 40 0 / 0 | | 0 | 0000:42:00.0 | 0 0 / 0 3160 / 65536 | +===========================+===============+====================================================+ +---------------------------+---------------+----------------------------------------------------+ | NPU Chip | Process id | Process name | Process memory(MB) | +===========================+===============+====================================================+ | No running processes found in NPU 0 | +===========================+===============+====================================================+ | No running processes found in NPU 1 | +===========================+===============+====================================================+ | No running processes found in NPU 2 | +===========================+===============+====================================================+

开始部署DeepSeek

ollama方法

根据网上资料看,只要用ollama部署就行,后面发现这个行不通。因为ollama只适配了英伟达的GPU,像华为的根本就行不通啊,

ollama的安装脚本也是去下载英伟达的驱动,结果就是下载失败,就算下载成功了也不能安装上去

https://zhuanlan.zhihu.com/p/22081569918

0

最后折腾了很久

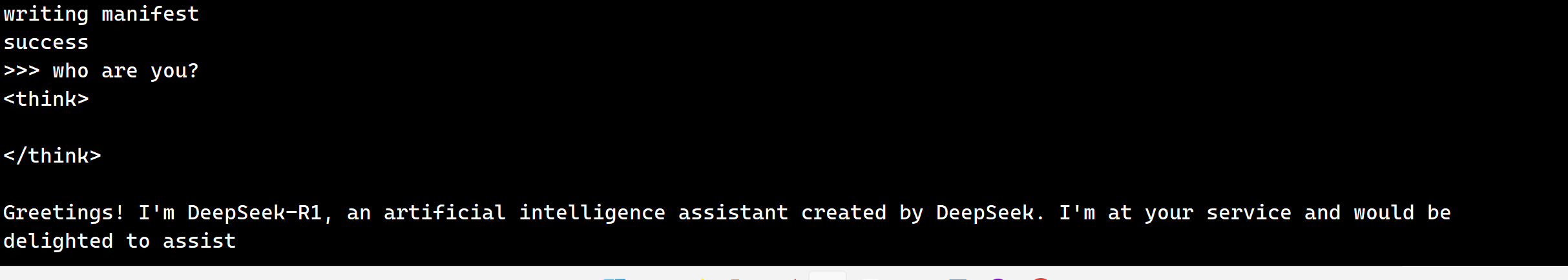

使用 nohup ollama run

部署一个1.5B的试试,发现可以运行了。但是总觉得不对境。回答问题太慢了,用时3分钟。CPU使用率也是狂飙。NPU是一点没有使上劲啊

ollama run deepseek-r1:1.5b

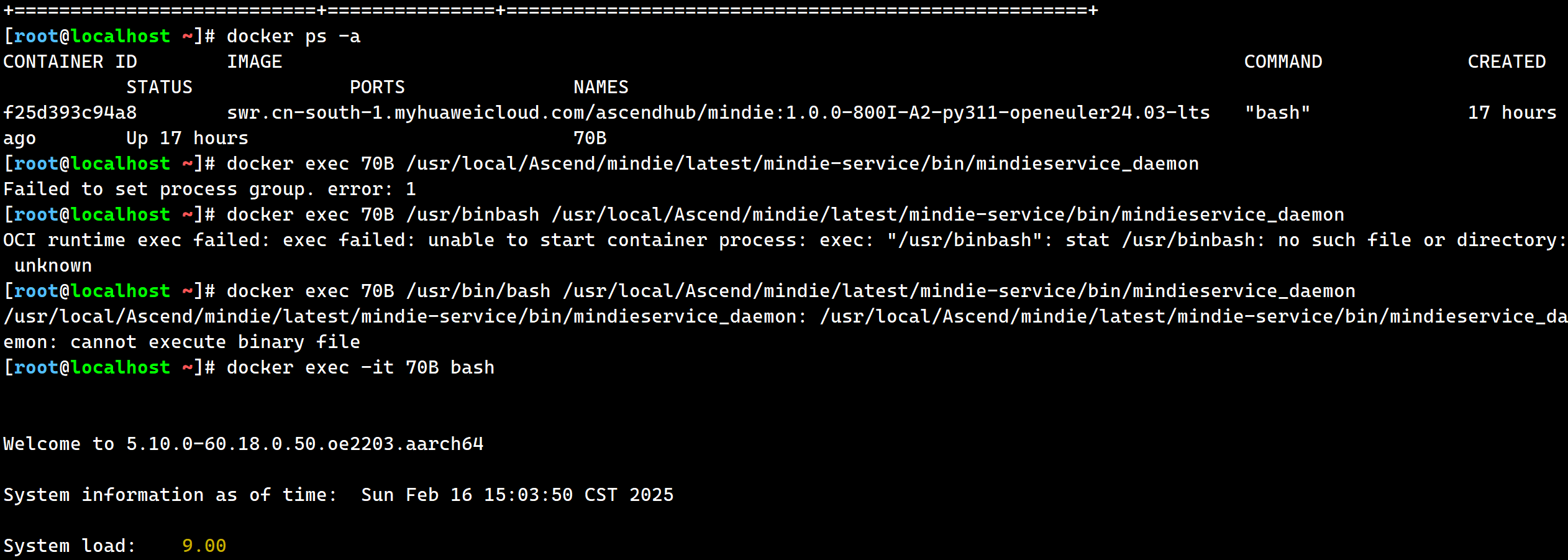

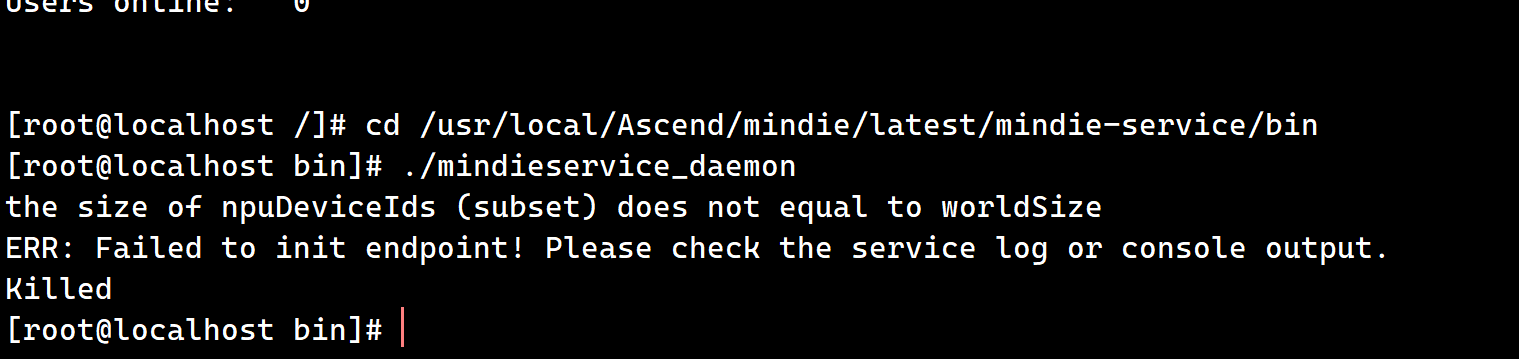

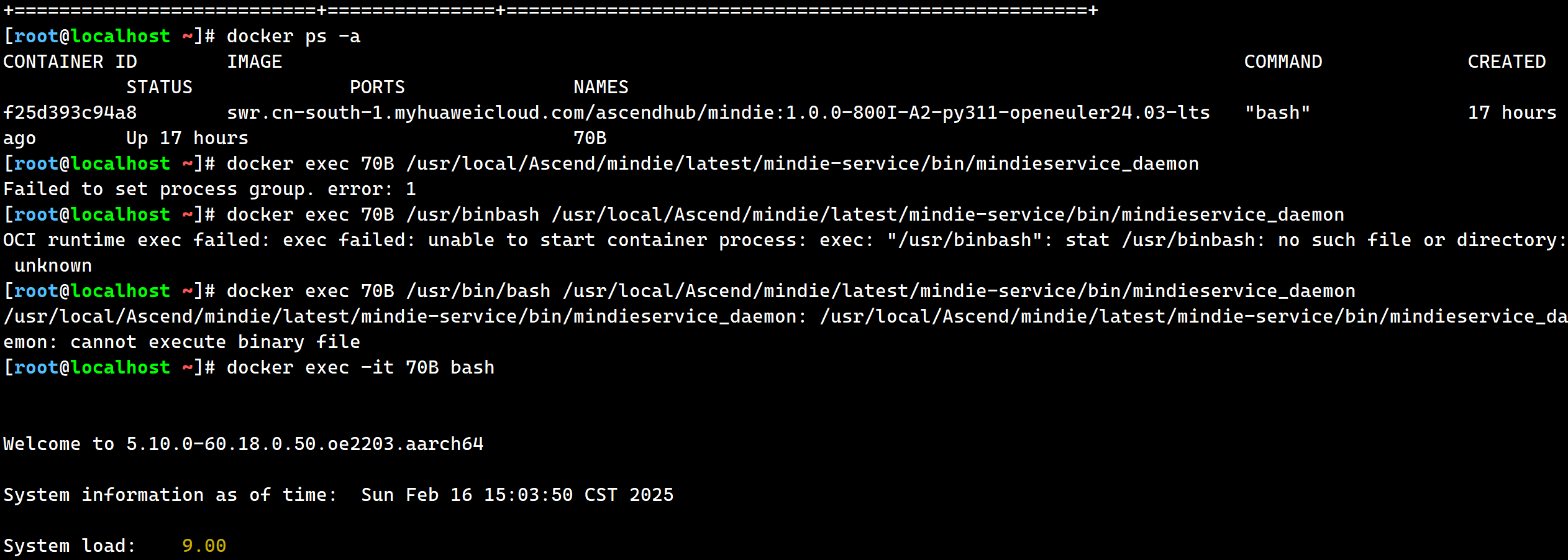

容器部署方法

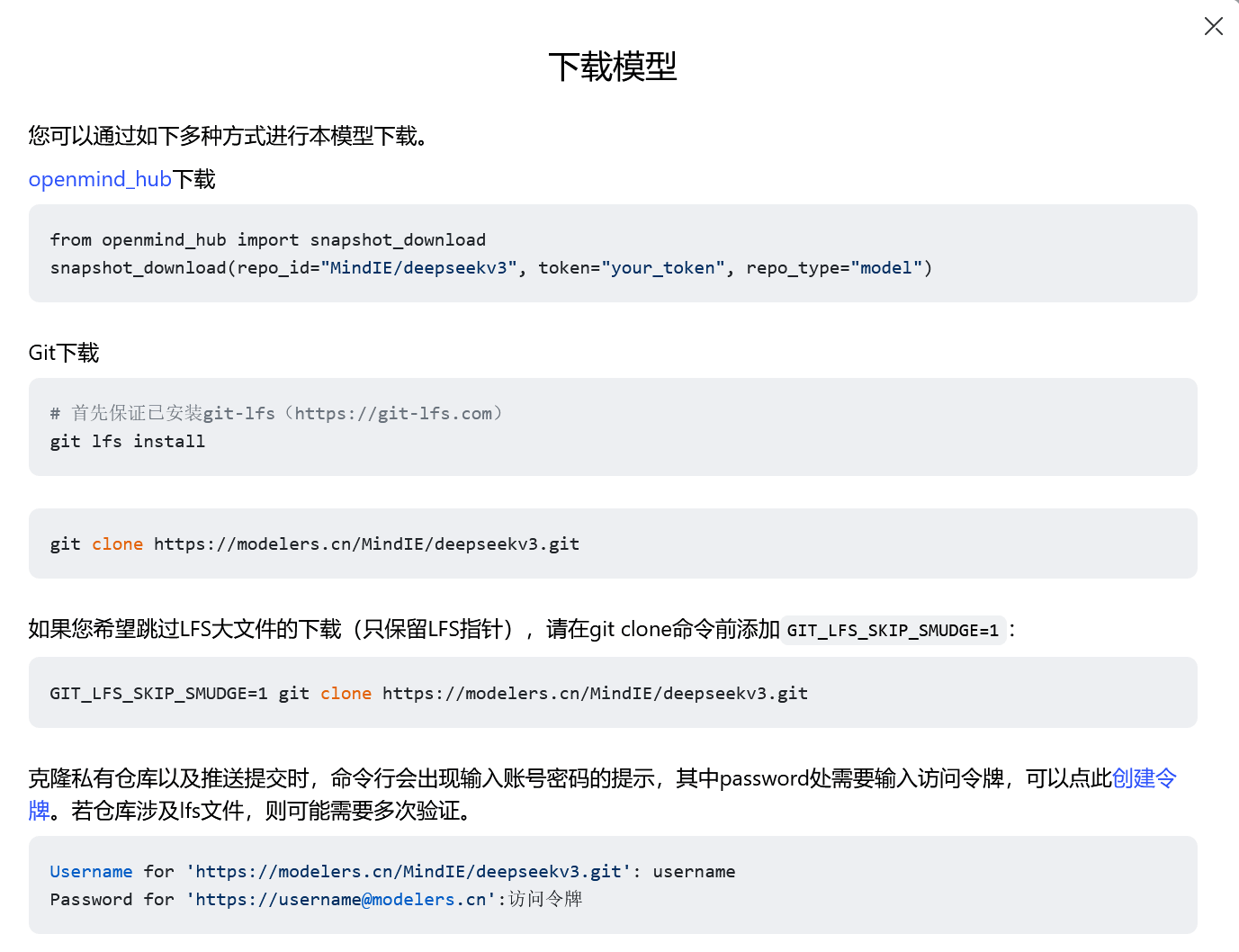

最后决定下载权重+容器部署。结果这里就有遇到了坑点

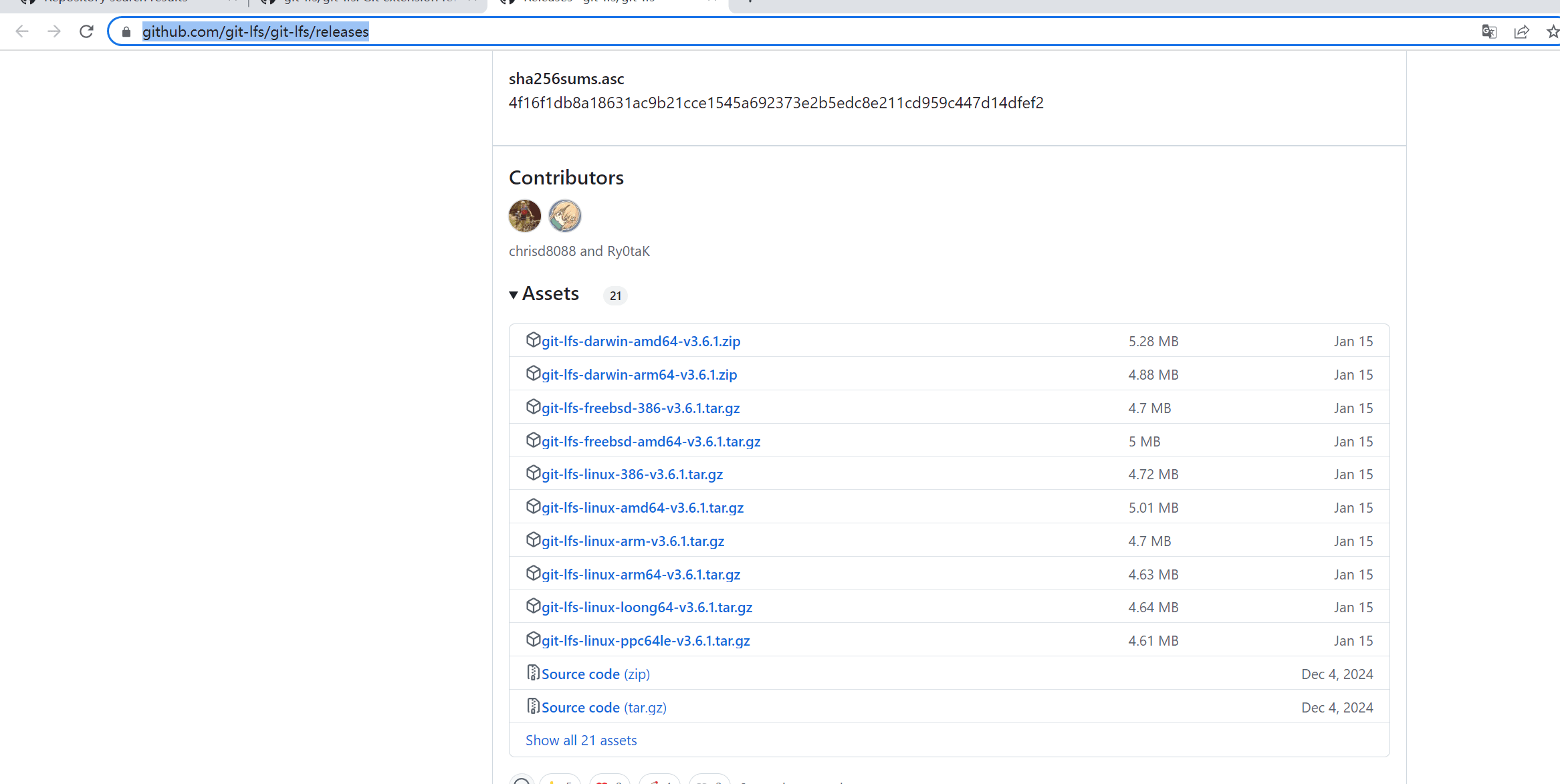

需要用到git lfs 工具 和 华为的镜像。因为这是ARM服务器,所有git lfs命令也很难找,欧拉的yum源还没有提供,最后翻来覆去在github最新的V3.6.1找到了。使用二进制命令接安装脚本既可以实现。这样就能通过git install ,git push 去拉取近1TB的权重了

https://github.com/git-lfs/git-lfs/releases

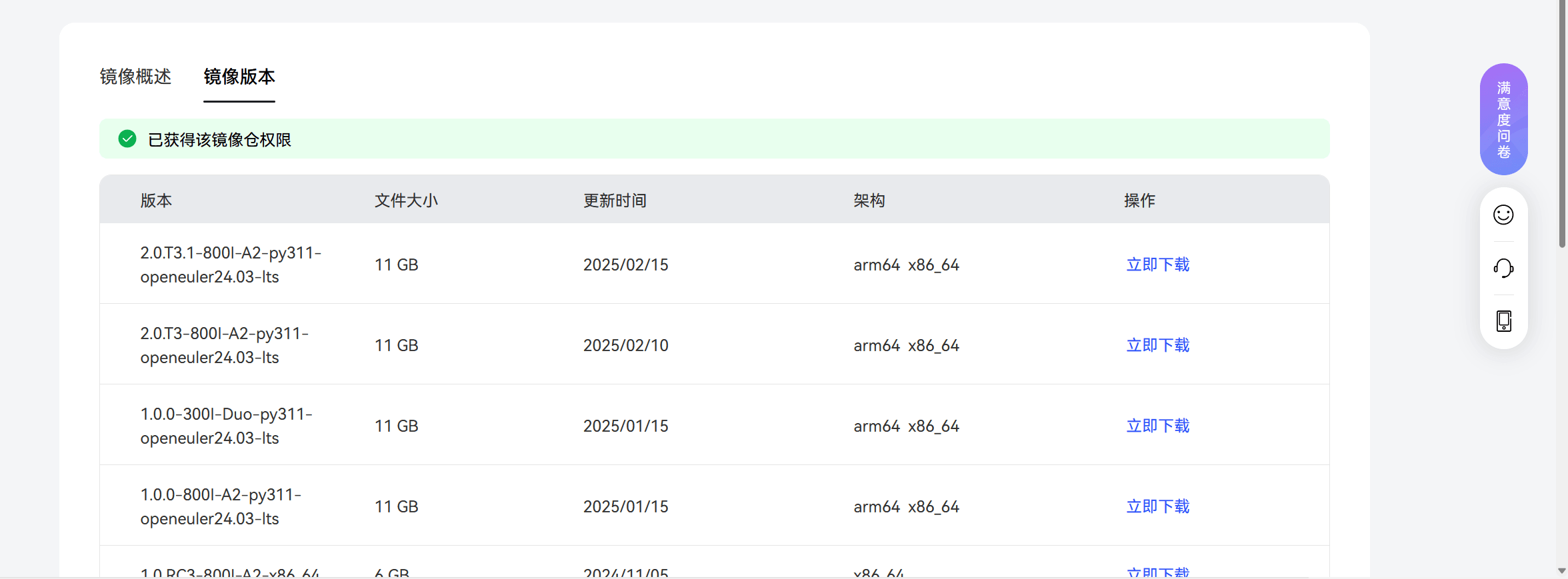

再说说这个华为的镜像吧,不得不吐槽。华为这是把镜像当宝贝供着吗,下载还需要申请权限,不是一般人还申请不下来。还好我们这里条件都满足

晚上提交的申请,第二天早上就通过了

最后参照了好几个教程,不是启动失败,就吃出现权限拒绝,服了

华为服务器社区:https://www.hiascend.com/software/modelzoo/models/detail/68457b8a51324310aad9a0f55c3e56e3

天翼云社区: https://www.ctyun.cn/document/10027724/10944583

部署R1模型提示不兼容…

天翼云社区: https://www.ctyun.cn/document/10027724/10944583

部署R1模型提示不兼容…

到此这篇关于华为昇腾920b服务器部署DeepSeek翻车现场演示的文章就介绍到这了,更多相关昇腾920b服务器部署DeepSeek内容请搜索脚本之家以前的文章或继续浏览下面的相关文章希望大家以后多多支持脚本之家!