Docker安装ollama过程解读

作者:坚定信念,勇往无前

Ollama是一个开源的LLM服务工具,用于简化在本地运行大语言模型,本文介绍了如何使用Docker安装Ollama并运行大语言模型,包括拉取镜像、运行容器和加载模型,最后,还介绍了如何安装OpenWebUI进行Web界面交互

一:ollama介绍

Ollama官网:https://ollama.com/,官方网站的介绍就一句话:

Get up and running with large language models. (开始使用大语言模型。)

Ollama是一个开源的 LLM(大型语言模型)服务工具,用于简化在本地运行大语言模型、降低使用大语言模型的门槛,使得大模型的开发者、研究人员和爱好者能够在本地环境快速实验、管理和部署最新大语言模型,包括如Qwen2、Llama3、Phi3、Gemma2等开源的大型语言模型。

因此:Ollama是大语言模型便捷的管理和运维工具

二:docker安装ollama

1.1 拉取镜像

docker pull ollama/ollama

运行容器(CPU)

docker run -d -v D:\ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama

说明:D:\ollama 挂载自己机器的目录

1.2 运行容器(GPU)

docker run -d --gpus=all -v D:\ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama

1.3 运行模型

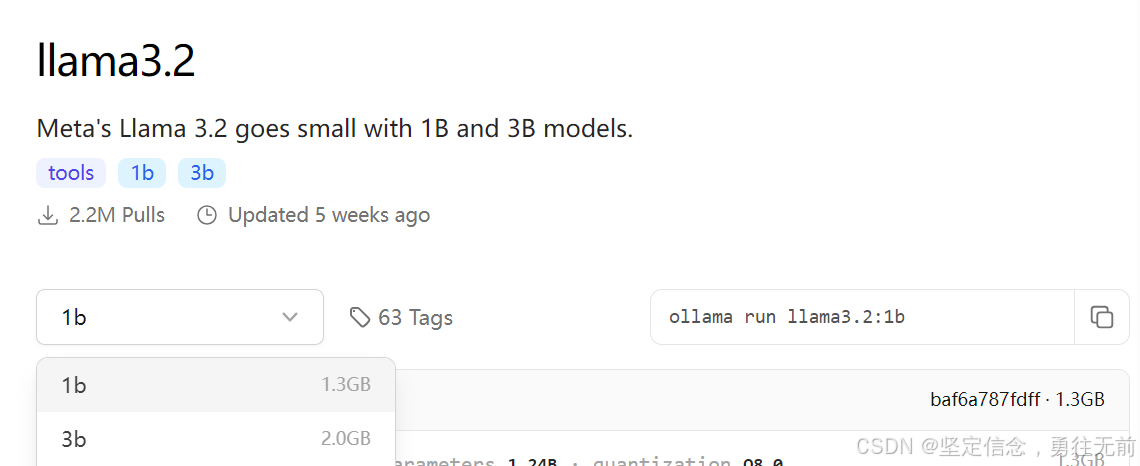

运行模型前首先要到https://ollama.com/library选择自己要加载的模型(上面有各种模型:llama3.2,llama3.1,gemma2,qwen2.5,等等),我们在这选择11ama3.2

从上图可以看到下拉里面有几个不同数据量的版本。选择好了之后。我们会看对应右边文本框里面会有对应的变化,我们现在选择1b对应的就是:ollama run llama3.2:1b

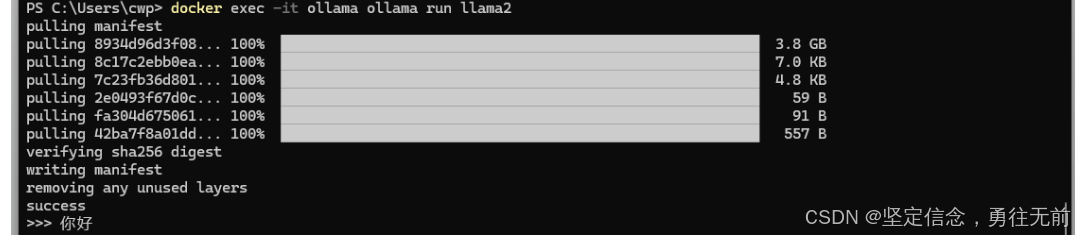

下一步:我们就把选择这个模型运行下。如果没有下载他会自动下载的。

docker exec -it ollama ollama run llama3.2:1b

docker exec 命令:

docker exec是用来在一个已经运行的容器内执行命令的。- 它允许你在容器内部启动一个新的进程,通常用于调试和管理。

it选项:

i(interactive): 使容器的标准输入保持打开,以便你可以与容器内的进程进行交互。t(tty): 为容器分配一个伪终端,这使得你可以以终端模式运行命令。

ollama:

- 这是正在运行的容器的名称。

- 刚刚通过

docker run命令启动了这个容器,并给它指定了名称ollama。

ollama run llama3.2:1b:

- 这是在容器内执行的命令。

- 它调用了

ollama应用程序,并加载llama3.2:1b模型(这个就是我们在官网上面选择那个版本)

运行图片如下:

这样你就可以用这个客户端跟大模型对话。

最后:当然我们需要一下web-ui跟大模型对话了。下一步讲如何安装Open WebUI

总结

以上为个人经验,希望能给大家一个参考,也希望大家多多支持脚本之家。