python使用 multiprocessing 多进程处理批量数据的示例代码

作者:DexterLien

这篇文章主要介绍了使用 multiprocessing 多进程处理批量数据的示例代码,本文通过示例代码给大家介绍的非常详细,对大家的学习或工作具有一定的参考借鉴价值,需要的朋友可以参考下

示例代码

import multiprocessing

def process_data(data):

# 这里是处理单个数据的过程

return data * 2

# 待处理的数据

data = [1, 2, 3, 4, 5]

def normal_func():

# 普通处理方式

result = []

for obj in data:

result.append(process_data(obj)

return result

def parallel_func():

# 多进程处理方式

pool = multiprocessing.Pool(multiprocessing.cpu_count())

result = pool.map(process_data, data)

pool.close()

return result

if __name__ == '__main__':

result = normal_func()

result = parallel_func()multiprocessing.Pool 创建进程池, 传入的参数是要要使用的 CPU 内核数量, 直接用 cpu_count() 可以拿到当前硬件配置所有的 CPU 内核数.

pool.map 可以直接将处理后的结果拼接成一个 list 对象

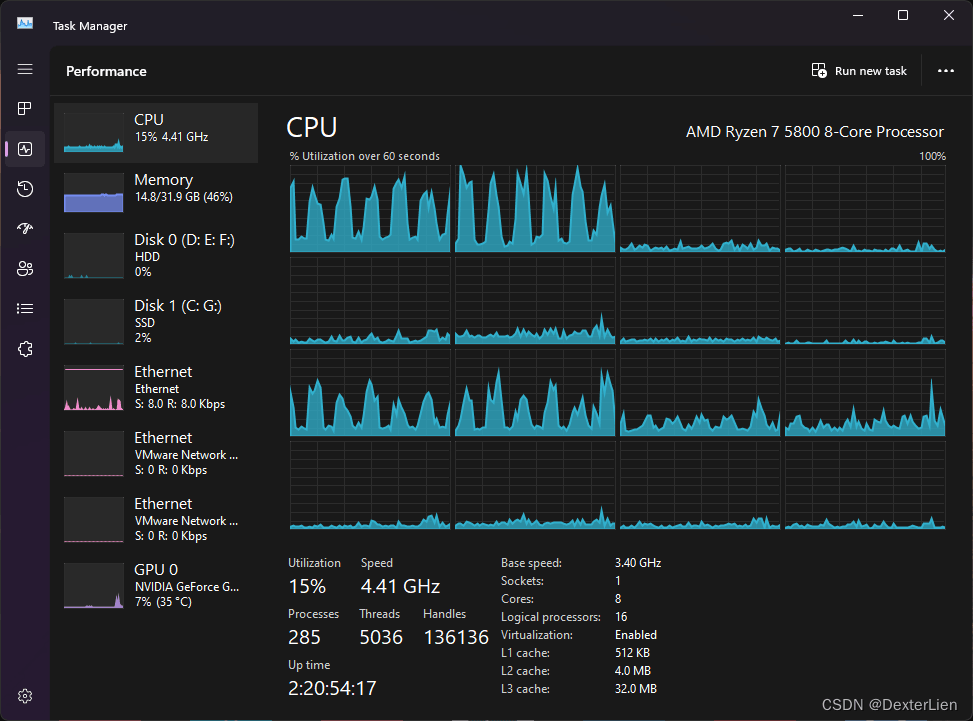

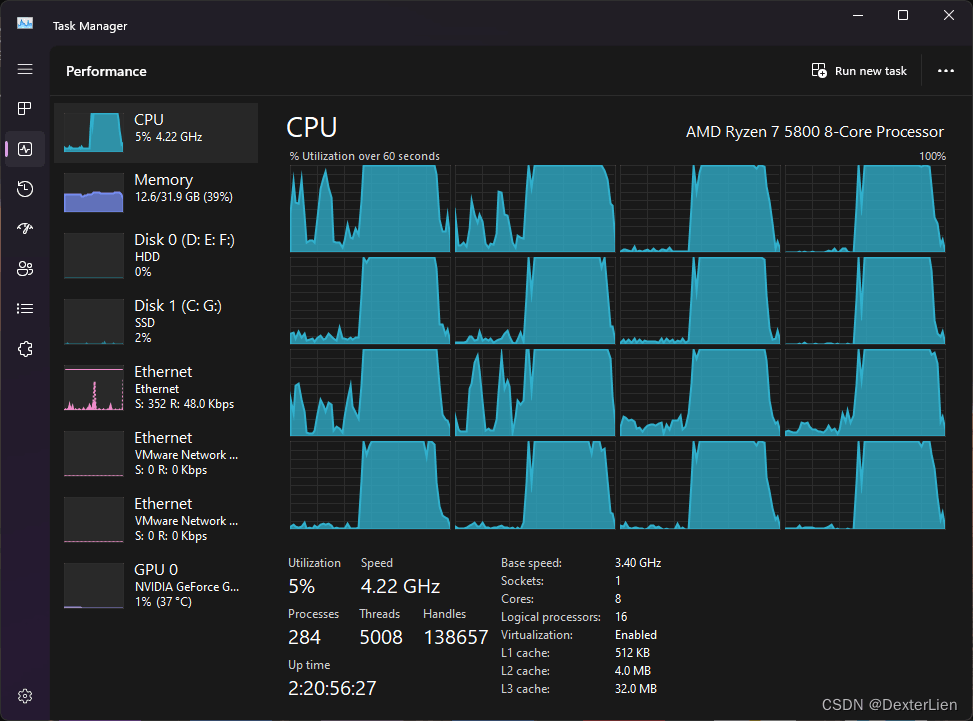

应用在实际数据处理代码的效果对比:

普通处理方式, 用时 221 秒

多进程处理方式, 用时 39 秒, 节省了 82% 的时间

到此这篇关于使用 multiprocessing 多进程处理批量数据的文章就介绍到这了,更多相关 multiprocessing 多进程处理批量数据内容请搜索脚本之家以前的文章或继续浏览下面的相关文章希望大家以后多多支持脚本之家!