使用Java实现延迟追加音频效果的纯本地方案(不依赖FFmpeg)

作者:一键难忘

一、背景介绍

在音频后期处理中,“延迟”是一种常见的声音特效。

例如:

- 在语音合成或自动配音系统中,用于制造时间间隔;

- 在多音轨合成中,用于对齐音频段落;

- 在背景音乐处理时,用于延后进入或淡入效果。

过去,大多数开发者会选择 FFmpeg 来实现延迟效果,例如通过命令:

ffmpeg -i input.wav -af "adelay=1000|1000" output.wav

但在某些 Java 应用场景(如 SaaS 音频服务、本地工具、Android 桌面端),

出于部署简化、性能、或许可协议等考虑,我们希望完全摆脱 FFmpeg,实现纯 Java 方案。

本篇文章将介绍如何使用 Java 原生音频 API (javax.sound.sampled 包) 实现一个延迟音频效果的追加逻辑:

不依赖任何外部命令行工具,直接生成带延迟的音频文件(WAV 格式)。

二、功能目标

我们要实现的函数是:

在一段音频的前面 插入一段指定时长的静音区(无声部分),

让整段音频“延迟”播放或合并到其他轨道中。

核心逻辑如下:

- 输入:原始音频文件路径、输出路径、延迟时间(毫秒)

- 输出:新的 WAV 文件,其中前面增加了指定时间长度的静音

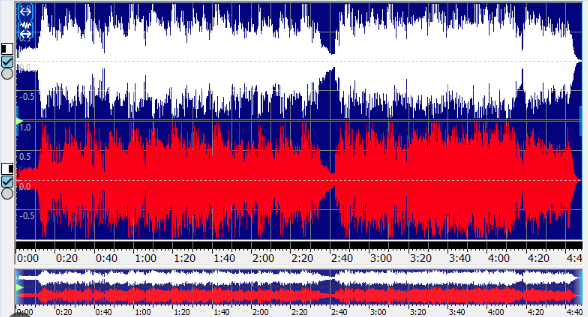

最终效果如下图所示:

原始音频: |========音频内容========| 延迟后音频: |------静音------|========音频内容========|

三、Java 实现原理分析

在 Java 的 javax.sound.sampled API 中,我们可以用 AudioInputStream 表示音频流。

要实现“延迟追加”,只需:

- 计算静音区对应的字节长度

- 构造一段空白(静音)的字节流

- 通过

SequenceInputStream将静音流与原音频流拼接 - 使用

AudioSystem.write()输出新音频文件

整个过程完全在内存中完成,无需外部依赖。

四、关键实现逻辑

以下为核心思路解析(代码节选说明,完整实现见文末):

1. 读取音频格式信息

首先读取原始音频文件,并获取其格式描述:

AudioInputStream originStream = AudioSystem.getAudioInputStream(new File(origin)); AudioFormat format = originStream.getFormat();

AudioFormat 包含采样率、采样位数、声道数、帧大小等关键信息。

这些信息是我们后续计算延迟长度的基础。

2. 计算延迟区长度

延迟时长由用户指定(单位:毫秒)。

我们需要将时间转换为帧数,再转换为字节数:

int frameSize = format.getFrameSize(); float frameRate = format.getFrameRate(); long delayFrames = (long) ((ms / 1000.0) * frameRate); long delayBytes = delayFrames * frameSize;

举例:

采样率 44100Hz、帧大小 4字节、延迟 1000ms

→ delayFrames = 44100,delayBytes = 44100 * 4 = 176400 字节。

3. 构造静音区

WAV 的静音数据就是全 0 字节,因此我们可以这样生成:

byte[] silenceBuffer = new byte[(int) delayBytes]; Arrays.fill(silenceBuffer, (byte) 0);

然后,将这段静音字节包裹成音频流:

ByteArrayInputStream silenceStream = new ByteArrayInputStream(silenceBuffer); AudioInputStream silenceAudioStream = new AudioInputStream(silenceStream, format, delayFrames);

4. 拼接音频流

Java 的 SequenceInputStream 支持顺序拼接两个输入流。

我们可以轻松把“静音流”和“原音频流”接起来:

AudioInputStream appendedStream = new AudioInputStream(

new SequenceInputStream(silenceAudioStream, originStream),

format,

silenceAudioStream.getFrameLength() + originStream.getFrameLength()

);

这样,新的音频流就表示:

静音片段 + 原音频。

5. 写出新音频文件

最后一步,将合成后的音频流写入目标文件:

AudioSystem.write(appendedStream, AudioFileFormat.Type.WAVE, new File(target));

然后记得关闭所有流资源。

五、完整实现代码

完整实现如下(支持 PCM WAV 文件):

public static void delayAppend(String origin, String target,

long ms) throws IOException, UnsupportedAudioFileException {

// 打开原始音频文件

File originFile = new File(origin);

AudioInputStream originStream = AudioSystem.getAudioInputStream(originFile);

AudioFormat format = originStream.getFormat();

// 计算延迟部分的字节长度

int frameSize = format.getFrameSize();

float frameRate = format.getFrameRate();

long delayFrames = (long)((ms / 1000.0) * frameRate);

long delayBytes = delayFrames * frameSize;

// 创建延迟部分(静音区)

byte[] silenceBuffer = new byte[(int)delayBytes];

// 填充静音(所有字节为0表示无声)

for (int i = 0; i < silenceBuffer.length; i++) {

silenceBuffer[i] = 0;

}

// 创建输入流用于拼接(静音 + 原音频)

ByteArrayInputStream silenceStream = new ByteArrayInputStream(silenceBuffer);

AudioInputStream silenceAudioStream = new AudioInputStream(silenceStream, format, delayFrames);

// 拼接流(顺序输入:静音 → 原音频)

AudioInputStream appendedStream = new AudioInputStream(

new SequenceInputStream(silenceAudioStream, originStream), format,

silenceAudioStream.getFrameLength() + originStream.getFrameLength());

// 写出为目标文件(WAV 格式)

AudioSystem.write(appendedStream, AudioFileFormat.Type.WAVE, new File(target));

// 关闭资源

appendedStream.close();

originStream.close();

silenceAudioStream.close();

}

六、优点与应用场景

优点

- 纯 Java 实现:无 FFmpeg,无需安装依赖;

- 高可移植性:可运行于 Windows、macOS、Linux;

- 内存友好:按帧拼接流,避免整段音频加载到内存;

- 安全可控:便于集成至 Java 服务端或桌面端应用。

应用场景

- TTS(文字转语音)系统中的延迟播放控制;

- 多音轨合成时的时间对齐处理;

- 游戏引擎中背景音乐的延迟进入效果;

- 自动配音项目中多片段拼接的预处理。

七、总结

通过本文,我们展示了如何仅使用 Java 标准库实现音频延迟追加效果。

整个实现没有依赖任何外部工具,逻辑清晰、可扩展性强。

这为我们在“去 FFmpeg 化”的音频处理方向上,提供了一个可行的、高效的解决思路。

如果你需要更复杂的音频操作(如回声、混响、淡入淡出、声道混合等),

都可以在此基础上,结合 AudioInputStream 与样本数据处理,进一步扩展。

本文介绍了如何使用 Java 原生音频 API(javax.sound.sampled) 实现一个无需依赖 FFmpeg 的延迟音频追加效果。通过在音频开头插入一段静音数据,实现了音频整体“后移”的延迟播放效果。整个实现过程仅依赖 Java 标准库,具有良好的跨平台性与可移植性,非常适合应用于 语音合成、音频拼接、配音系统、音轨对齐 等场景。此方案不仅简洁高效,还为开发者提供了更灵活、安全的音频处理能力,进一步展示了 Java 在多媒体处理领域的潜力。

以上就是使用Java实现延迟追加音频效果的纯本地方案(不依赖FFmpeg)的详细内容,更多关于Java延迟追加音频效果的资料请关注脚本之家其它相关文章!