如何用websocket+webRtc后端实现视频通话

作者:RanOver.

WebRTC 和WebSocket是两种不同的技术,虽然它们都用于在浏览器之间进行通信,但它们的设计目标和使用场景有所不同,这篇文章主要介绍了如何用websocket+webRtc后端实现视频通话的相关资料,需要的朋友可以参考下

WebRTC(Web Real-Time Communication)是一种实时通信技术,允许网络应用或站点在不借助中间媒介的情况下,建立浏览器之间的点对点(Peer-to-Peer)连接,实现视频流、音频流或其他任意数据的传输。WebRTC不需要用户安装任何插件或第三方软件,即可在浏览器之间直接进行音视频通信和数据共享

要实现基于WebRTC和WebSocket的视频通话,可以按照以下步骤进行:

建立WebSocket连接:首先,在应用程序中使用WebSocket建立双向通信的连接。WebSocket连接可以用来传输WebRTC的SDP(Session Description Protocol)和Candidate信息。

使用WebRTC建立连接:当WebSocket连接建立后,双方可以使用WebRTC来建立音视频通话的连接。这包括以下步骤:

- 获取本地媒体流:使用getUserMedia API获取本地摄像头和麦克风的音视频流。

- 建立PeerConnection:创建RTCPeerConnection对象,用于处理音视频流的传输和处理。

- 创建和交换SDP:通过WebSocket传输SDP信息,包括Offer和Answer,以建立网络对等连接。

- ICE候选人交换:通过WebSocket传输ICE候选人信息,以帮助双方建立对等连接并克服NAT和防火墙限制。

传输音视频数据:一旦建立了WebRTC连接,双方就可以通过PeerConnection来传输音视频数据流。

实现信令服务器:在实际应用中,通常需要一个信令服务器来处理建立和管理WebRTC连接过程中的信令交换。这个服务器负责转发SDP和ICE候选人信息,以确保双方能够建立正确的连接。

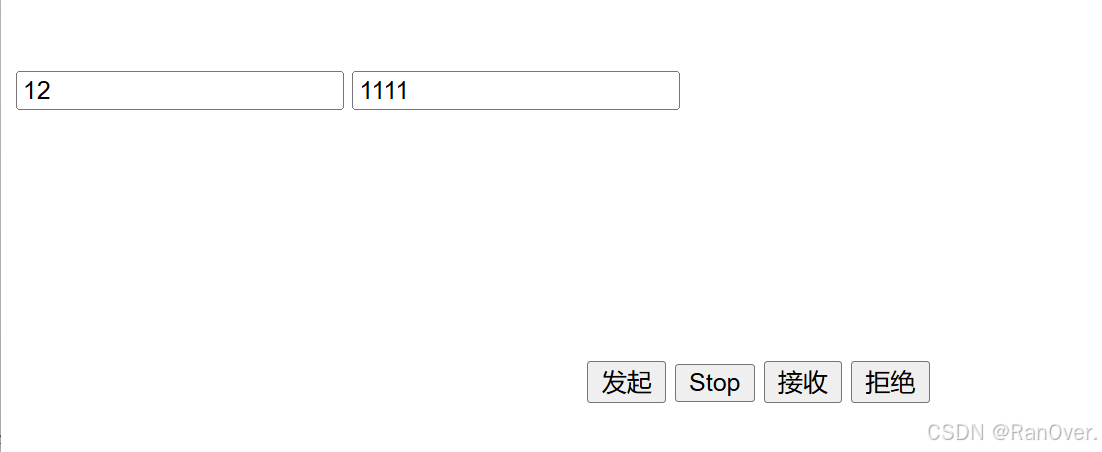

默默写了一个前后端的demo....

websocket之前我这边已经建立过连接了,现在就是新加webRtc的东西

<dependency>

<groupId>org.springframework</groupId>

<artifactId>spring-websocket</artifactId>

</dependency>@Data

public class WebRTCSignalingMessage extends IMCommand {

private String type;// 消息类型

private Object offer; // offer内容

private Object iceCandidate; // iceCandidate信息

private Object answer; // answer数据

private String fromUserId; //用户id

private String targetUserId; // 目标用户ID

}public class RtpPacketDecoder extends ReplayingDecoder<Void> {

@Override

protected void decode(ChannelHandlerContext ctx, ByteBuf in, List<Object> out) throws Exception {

int header = in.readUnsignedByte();

int version = (header >> 6) & 0x3;

int padding = (header >> 5) & 0x1;

int extension = (header >> 4) & 0x1;

int cc = header & 0xf;

header = in.readUnsignedByte();

int marker = (header >> 7) & 0x1;

int payloadType = header & 0x7f;

int sequenceNumber = in.readUnsignedShort();

int timestamp = in.readInt();

int ssrc = in.readInt();

int payloadLength = in.readableBytes();

byte[] payload = new byte[payloadLength];

in.readBytes(payload);

out.add(new RtpPacket(version, padding, extension, cc, marker, payloadType, sequenceNumber, timestamp, ssrc, payload));

}

}// RTP数据包编码器

public class RtpPacketEncoder extends MessageToByteEncoder<RtpPacket> {

/**

* 编码方法,将RtpPacket对象编码为字节流

*

* @param ctx 上下文对象,包含通道信息

* @param packet 待编码的RtpPacket对象

* @param out ByteBuf对象,用于存储编码后的字节流

* @throws Exception 编码过程中可能抛出的异常

*/

@Override

protected void encode(ChannelHandlerContext ctx, RtpPacket packet, ByteBuf out) throws Exception {

// 构造RTP头的第一个字节

byte header = (byte) ((packet.getVersion() << 6) | (packet.getPadding() << 5) |

(packet.getExtension() << 4) | packet.getCc());

out.writeByte(header);

// 构造RTP头的第二个字节

header = (byte) ((packet.getMarker() << 7) | packet.getPayloadType());

out.writeByte(header);

// 写入序列号

out.writeShort(packet.getSequenceNumber());

// 写入时间戳

out.writeInt(packet.getTimestamp());

// 写入SSRC

out.writeInt(packet.getSsrc());

// 如果有效载荷不为空,则写入有效载荷

if (packet.getPayload()!= null) {

out.writeBytes(packet.getPayload());

}

}

}

@Slf4j

public class MediaStreamForwarder extends SimpleChannelInboundHandler<RtpPacket> {

@Override

protected void channelRead0(ChannelHandlerContext ctx, RtpPacket packet) throws Exception {

// 这里简单地将RTP数据包转发给所有其他客户端,实际应用中需要更智能的转发逻辑

for (ChannelHandlerContext targetCtx : IMServer.USERS.values()) {

if (targetCtx!= ctx) {

targetCtx.writeAndFlush(packet);

}

}

}

@Override

public void exceptionCaught(ChannelHandlerContext ctx, Throwable cause) throws Exception {

log.error("Media stream forwarding error", cause);

ctx.close();

}

}

总结

到此这篇关于如何用websocket+webRtc后端实现视频通话的文章就介绍到这了,更多相关websocket+webRtc后端视频通话内容请搜索脚本之家以前的文章或继续浏览下面的相关文章希望大家以后多多支持脚本之家!