MySQL海量数据(2亿级表字段)无损更新方案

作者:码农阿豪@新空间

在大型互联网应用中,数据表动辄达到亿级规模,当需要对生产环境中的海量表进行字段更新时,如何在不影响业务正常读写的情况下完成任务,是每个DBA和开发者都会面临的挑战,本文将以一个真实案例详细讲解四种渐进式更新方案及其实现原理,需要的朋友可以参考下

一、问题背景与挑战

1.1 场景描述

- 表名:

statistics_data - 数据量:2亿条记录

- 需求:将

timeout字段全部更新为0 - 约束条件:业务持续运行,不能有显著影响

1.2 核心难点

- 锁争用风险:全表更新可能导致长时间锁表

- 主从延迟:大批量操作产生大量binlog

- 性能波动:CPU/IO压力影响正常查询响应

- 进度控制:需要可中断、可监控的方案

二、四大解决方案对比

2.1 方案一:直接全表更新(不推荐)

-- 危险操作!会导致长时间锁表 UPDATE statistics_data SET timeout = 0;

缺陷:

- 产生单个大事务,锁定全表直到完成

- 可能触发undo空间爆满

- 回滚成本极高

2.2 方案二:分批更新(推荐)

Shell脚本实现

#!/bin/bash

# 分批更新脚本(每10万条间隔1秒)

while true; do

affected=$(mysql -uroot -p$PWD -e "

UPDATE statistics_data

SET timeout = 0

WHERE timeout != 0

LIMIT 100000;

SELECT ROW_COUNT();" | tail -1)

[ $affected -eq 0 ] && break

sleep 1

done

优势:

- 每次只锁定少量行

- 可通过调整LIMIT值控制单次影响

执行效果监控

-- 查看剩余待更新量 SELECT COUNT(*) FROM statistics_data WHERE timeout != 0;

2.3 方案三:pt-online-schema-change

Percona工具链的黄金方案:

pt-online-schema-change \ --alter "MODIFY timeout INT DEFAULT 0" \ D=database,t=statistics_data \ --execute

原理:

- 创建影子表(结构+新字段定义)

- 增量同步原表数据到影子表

- 原子切换表名

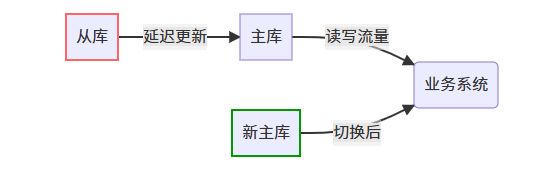

2.4 方案四:主从切换更新

操作步骤:

- 在从库执行全量更新

- 主从切换(需配合VIP或DNS切换)

- 原主库作为新从库追平数据

三、Python自动化实现详解

3.1 完整脚本代码

import pymysql

import time

import sys

def batch_update(config):

conn = pymysql.connect(config)

cursor = conn.cursor()

# 获取总记录数

cursor.execute("SELECT COUNT(*) FROM statistics_data WHERE timeout != 0")

total = cursor.fetchone()[0]

print(f"待更新记录总数: {total}")

batch_size = 100000

updated = 0

start = time.time()

try:

while updated < total:

sql = f"""

UPDATE statistics_data

SET timeout = 0

WHERE timeout != 0

LIMIT {batch_size}

"""

cursor.execute(sql)

count = cursor.rowcount

conn.commit()

updated += count

progress = updated / total * 100

print(f"\r进度: {updated}/{total} ({progress:.2f}%)", end="")

if count == batch_size:

time.sleep(1) # 主动暂停降低负载

except Exception as e:

conn.rollback()

print(f"\n错误发生: {str(e)}")

finally:

cursor.close()

conn.close()

print(f"\n更新完成! 耗时: {time.time()-start:.2f}秒")

if __name__ == "__main__":

db_config = {

'host': '10.0.0.5',

'port': 3307, # 非标准端口示例

'user': 'admin',

'password': 'safe@123',

'db': 'stats_db',

'connect_timeout': 60

}

batch_update(db_config)

3.2 关键优化点

动态进度显示

print(f"\r进度: {updated}/{total} ({progress:.2f}%)", end="")

\r实现行内刷新输出- 避免日志刷屏

自适应批次调整

if os.getloadavg()[0] > 5.0:

batch_size = max(50000, batch_size // 2)

- 连接池支持

from DBUtils.PooledDB import PooledDB pool = PooledDB(pymysql, db_config)

四、原理深度解析

4.1 InnoDB的锁机制

-- 查看当前锁状态 SELECT * FROM performance_schema.events_waits_current WHERE EVENT_NAME LIKE '%lock%';

- 行锁(Record Lock):仅锁定被更新的记录

- 间隙锁(Gap Lock):WHERE条件无索引时会升级

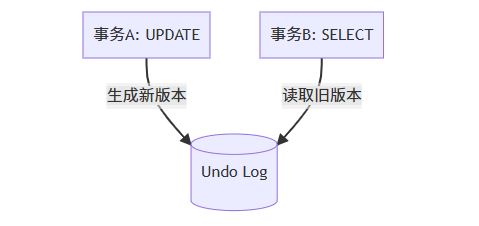

4.2 MVCC如何保障读写分离

- 读操作访问

read_view快照 - 写操作创建新版本记录

4.3 事务拆分最佳实践

# 每批次提交后立即释放锁 conn.commit() time.sleep(0.5) # 故意留出锁释放窗口

五、生产环境注意事项

前置检查清单

- 确认备库磁盘空间足够(至少2倍表大小)

- 检查

innodb_buffer_pool_size是否足够 - 备份

mysqldump -–single-transaction stats_db statistics_data

熔断机制

if time.localtime().tm_hour in range(9,18): # 白天工作时间

print("禁止在业务高峰执行!")

sys.exit(1)

- 监控指标

watch -n 1 "mysqladmin ext | grep -E 'Threads_running|Queries'"

结语

通过分批更新、工具辅助、架构调整三种维度的解决方案,配合Python自动化脚本的实现,我们成功实现了2亿级数据表的无损更新。建议读者在实际操作前:

- 在测试环境验证脚本

- 提前与业务方沟通维护窗口

- 准备好回滚方案(如:通过备份恢复)

经验法则:对于超过1亿行的表,单次操作数据量控制在10万条以内,间隔时间不少于0.5秒,可确保业务平稳运行。

以上就是MySQL海量数据(2亿级表字段)无损更新方案的详细内容,更多关于MySQL数据无损更新的资料请关注脚本之家其它相关文章!