python决策树之CART分类回归树详解

作者:zhihua_oba

决策树之CART(分类回归树)详解,具体内容如下

1、CART分类回归树简介

CART分类回归树是一种典型的二叉决策树,可以处理连续型变量和离散型变量。如果待预测分类是离散型数据,则CART生成分类决策树;如果待预测分类是连续型数据,则CART生成回归决策树。数据对象的条件属性为离散型或连续型,并不是区别分类树与回归树的标准,例如表1中,数据对象

2、CART分类回归树分裂属性的选择

2.1 CART分类树——待预测分类为离散型数据

选择具有最小

对于样本集

其中,在样本集

对于含有

其中,

对于属性

对于样本集

所得到的属性

2.2 CART回归树——待预测分类为连续型数据

区别于分类树,回归树的待预测分类为连续型数据。同时,区别于分类树选取

针对含有连续型分类结果的样本集

其中,

对于含有

对于属性

对于样本集

所得到的属性

3、CART分类回归树的剪枝

由于决策树的建立完全是依赖于训练样本,因此该决策树对训练样本能够产生完美的拟合效果。但这样的决策树对于测试样本来说过于庞大而复杂,可能产生较高的分类错误率。这种现象就称为过拟合。因此需要将复杂的决策树进行简化,即去掉一些节点解决过拟合问题,这个过程称为剪枝。

剪枝方法分为预剪枝和后剪枝两大类。预剪枝是在构建决策树的过程中,提前终止决策树的生长,从而避免过多的节点产生。预剪枝方法虽然简单但实用性不强,因为很难精确的判断何时终止树的生长。后剪枝是在决策树构建完成之后,对那些置信度不达标的节点子树用叶子结点代替,该叶子结点的类标号用该节点子树中频率最高的类标记。后剪枝方法又分为两种,一类是把训练数据集分成树的生长集和剪枝集;另一类算法则是使用同一数据集进行决策树生长和剪枝。常见的后剪枝方法有CCP(Cost Complexity Pruning)、REP(Reduced Error Pruning)、PEP(Pessimistic Error Pruning)、MEP(Minimum Error Pruning)。其中,悲观错误剪枝法PEP(Pessimistic Error Pruning)在“决策树之C4.5算法详解”中有详细介绍,感兴趣的小童鞋可以了解学习。这里我们详细介绍CART分类回归树中应用最广泛的剪枝算法——代价复杂性剪枝法CCP(Cost Complexity Pruning)。

代价复杂性剪枝法CCP(Cost Complexity Pruning)主要包含两个步骤:(1)从原始决策树

CCP剪枝法步骤(1)

生成子树序列

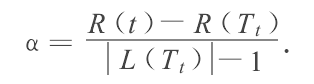

其中,

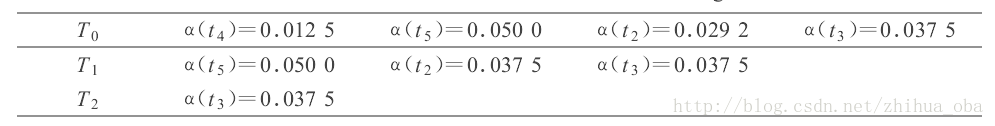

例如:图1中

图1,决策树中训练样本总个数为80。对于节点

表2

从表2可以看出,在原始树

CCP剪枝法步骤(2)

如何根据第1步产生的子树序列

参考文献

[1] 魏红宁. 决策树剪枝方法的比较[J]. 西南交通大学学报, 2005, 40(1):44-48.

[2] 张宇. 决策树分类及剪枝算法研究[D]. 哈尔滨理工大学, 2009.

[3] Breiman L, Friedman J H, Olshen R, et al. Classification and Regression Trees[J]. Biometrics, 1984, 40(3):358.

以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持脚本之家。